Sull’affidabilità dei modelli /2: gli ultimi – preoccupanti – scenari del progetto ENSEMBLES

Come anticipato nel precedente post, il “core” del progetto ENSEMBLES è consistito nell’individuare metodologie per un uso combinato di un gran numero di simulazioni prodotte da svariati GCMs (Modelli di Circolazione Generale dell’atmosfera) e RCMs (Modelli Climatici Regionali) finalizzate alla valutazione quantitativa, e statisticamente solida, dell’incertezza delle stesse. Lo sviluppo di tali nuovi sistemi di modellazione si è basato sulle ultime e più aggiornate versioni dei modelli disponibili presso i maggiori centri di produzione in Europa.

Come anticipato nel precedente post, il “core” del progetto ENSEMBLES è consistito nell’individuare metodologie per un uso combinato di un gran numero di simulazioni prodotte da svariati GCMs (Modelli di Circolazione Generale dell’atmosfera) e RCMs (Modelli Climatici Regionali) finalizzate alla valutazione quantitativa, e statisticamente solida, dell’incertezza delle stesse. Lo sviluppo di tali nuovi sistemi di modellazione si è basato sulle ultime e più aggiornate versioni dei modelli disponibili presso i maggiori centri di produzione in Europa.

Le simulazioni prodotte hanno reso disponibili nuovi scenari di cambiamento climatico, espressi anche in forma di probabilità di accadimento, cosa questa abbastanza nuova, rispetto ad esempio a quanto mostrato dal Quarto Rapporto IPCC. Il progetto si è sviluppato per 5 anni a partire dal 2004 ed è stato coordinato dal Servizio Meteorologico inglese, al cui interno opera Hadley Centre, uno dei centri di ricerca sul clima più importanti a livello mondiale, e ha visto la partecipazione di ben partner da 20 paesi in maggioranza europei, a cui si sono poi aggiunti altri 30 organizzazioni che non hanno usufruito dei fondi comunitari.

.

Nello specifico, gli argomenti trattati sono ricondotti a diversi temi di ricerca che possono essere riassunti in:

Nello specifico, gli argomenti trattati sono ricondotti a diversi temi di ricerca che possono essere riassunti in:

a) sviluppo di sistemi di previsione globale di Ensemble (EPS) attraverso uso combinato di modelli accoppiati atmosfera-oceano (AOGCMs);

b) produzione di nuove simulazioni a scala stagionale, decennale e centenaria;

c) formulazione di modelli regionali (Regional Climate Models-RCMs) ad alta risoluzione (circa 25 km) con i quali produrre scenari regionali dopo averne valutato l’attendibilità attraverso simulazioni con condizioni al contorno perfette (usando le rianalisi ERA40 prodotte dal Centro Europeo di Reading, ECMWF);

d) studio dettagliato dei processi che governano la variabilità del Clima e i suoi cambiamenti;

e) validazione delle diverse catene modellistiche, per quanto concerne la riproducibilità del clima attuale, attraverso l’uso di dati osservati e di analisi su grigliato del tutto indipendenti dai modelli utilizzati;

f) valutazione degli impatti su diversi settori di attività umane e su una vasta gamma di ecosistemi naturali;

g) esame dei diversi scenari prodotti con implicazioni anche sulle policy di applicazione di azioni di adattamento e mitigazione.

.

Non è possibile per ragioni di spazio e in un post necessariamente divulgativo riassumere gli innumerevoli risultati prodotti; il report finale (van der Linden P. e J.F.B. Mitchell, 2009) è per altro disponibile sul sito del progetto e merita di essere esaminato per comprendere quanto vasti siano stati gli ambiti di attività svolti.

In questo post si discutono solo pochi risultati, in particolare focalizzando l’attenzione agli scenari in area Mediterranea, e si farà esplicito riferimento al report di progetto sopra citato, a cui si rimanda per gli approfondimenti.

La conclusione principale di sintesi a cui ENSEMBLES giunge è che il continente europeo sarà interessato da una tangibile modifica del clima attuale nei prossimi decenni.

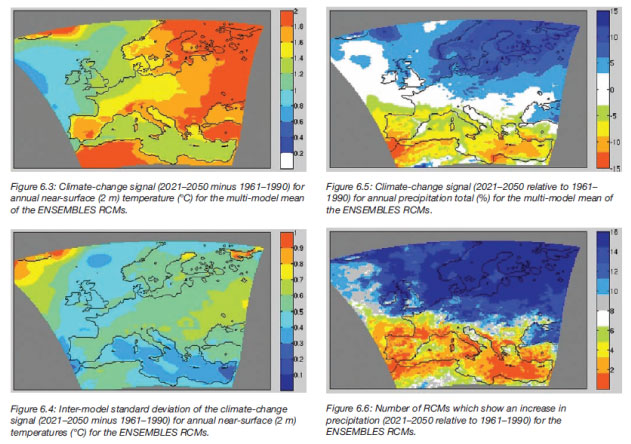

Ad esempio le figure 6.3, 6.4, 6.5 e 6.6 mostrate nel report sopra menzionato (pag. 61) mostrano degli scenari di cambiamento riferiti al trentennio 2021-2050 rispetto al 1961-1990 della temperatura a 2 metri dal suolo, media annuale (fig. 6.3) e della precipitazione totale annua (fig. 6.5), prodotti come media di Ensemble tra 16 diversi RCMs utilizzati. Le figure sottostanti (fig. 6.4 e fig. 6.6) rappresentano la variabilità inter-modello dei cambiamenti simulati, misurata dalla deviazione standard inter-modello per la temperatura (fig. 6.4) e dal numero di RCMs che mostrano un aumento, per la precipitazione (fig. 6.5).

E’ da notare come il segnale di aumento termico sia omogeneo sulla gran parte del continente europeo con punte tra 1.5 e 2 gradi e un’altrettanto evidente difformità di andamento tra Nord e Sud d’Europa per quanto concerne le precipitazioni, per le quali gli scenari mostrano un aumento in Nord Europa e una chiara diminuzione sul Mediterraneo.

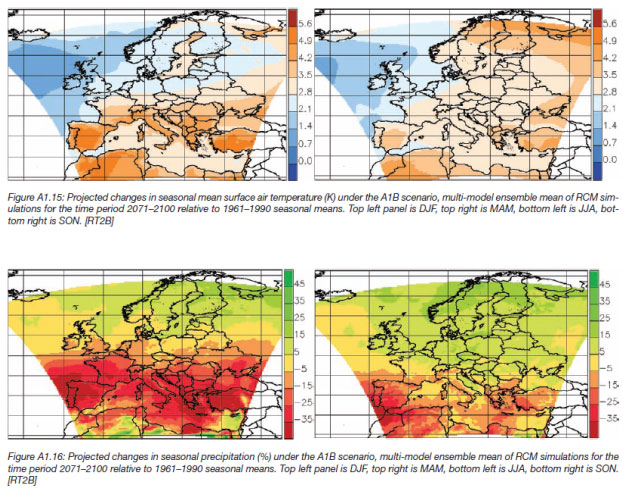

I risultati per la stagione estiva (vedi figura A1.11 posta in appendice al report, a pag. 145) sono ancora più significativi e mostrano un ancor maggior aumento delle temperature e una diminuzione più significativa delle piogge nell’area mediterranea (vedi figura A1.12, stessa pagina).

Gli scenari riferiti all’ultimo trentennio 2071-2100 amplificano la portata di questi cambiamenti per queste due grandezze (figure A1.15 e A1.16 del report).

La modesta variabilità tra i diversi modelli è una misura della solidità delle simulazioni e fa crescere la credibilità dei segnali di cambiamento nell’Area Mediterranea, caratteristica questa non sempre riscontrabile in altre aree del pianeta.

Da questo tipo di analisi emerge come siano presenti delle ampie zone europee con una forte coerenza nei pattern spaziali dei trend estivi e invernali delle temperature e precipitazioni (si veda ad esempio la figura 6.7 a pag. 61) e come siano allo stesso tempo anche presenti delle aree ampie in cui al contrario il segnale di cambiamento è poco significativo.

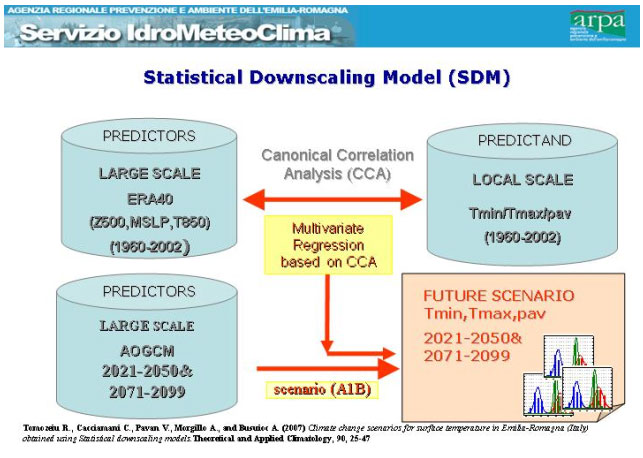

L’uso di diverse metodologie di Statistical Downscaling (SD) ha reso possibile la definizione degli scenari probabilistici di cambiamento a scale spaziali ancora più piccole, come ad esempio parti di paese europeo o addirittura piccole regioni amministrative. Le tecniche di SD si basano sulla definizione di set di predittori, estratti dai GCMs (ad esempio degli indici di circolazione in quota), che vengono connessi in modo statistico a dei “predittandi” (ad esempio le temperature al suolo). In genere il modello di SD viene calibrato usando dati osservati di predittori e predittandi; poi in fase di produzione di scenari di predittandi si usano le simulazioni dei predittori estratti dai GCMs.

Il vantaggio di queste tecniche sta nel fatto che sono poco onerose in termini computazionali e permettono di arrivare a dettagli spaziali molto piccoli, sino addirittura al livello del singolo osservatorio al suolo. Lo svantaggio è che non spiegano i processi fisici, come invece viene fatto dai RCMs, che però sono di molto più complessa realizzazione. Nella successiva figura è riportato un tipico approccio metodologico che caratterizza le tecniche di downscaling estratto da Tomozeiu e al. (2007), usato per la realizzazione di scenari probabilistici di temperatura e pioggia sul Nord Italia.

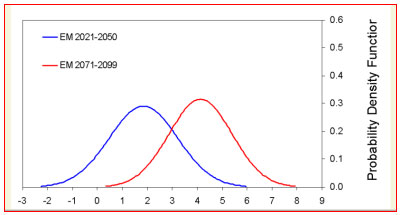

I risultati ottenuti nell’area del Nord Italia ottenuti applicando una tecnica di SD a 6 modelli globali (elaborazioni svolte da ARPA, Servizio IdroMeteoClima Emilia-Romagna, partner del progetto Ensembles), sono mostrati nella figura sottostante (questi risultati sono riportati nel quadro illustrativo mostrato all’inizio del par. 6.6.4 del report finale di Ensemble, pag. 76) ed evidenziano la struttura delle funzioni di distribuzione di probabilità, pdf delle anomalie di Temperatura Massima estiva proiettate ai trentenni 2021-2050 e 2071-2100 (le anomalie sono sempre valutate rispetto al trentennio 1961-1990). E’ evidente lo spostamento verso “destra” delle due funzioni di distribuzione, che nel periodo 2071-2100 vede il massimo centrato attorno a 4 gradi di aumento.

Cambiamenti della pdf della temperatura massima estiva sul Nord Italia (°C) Fonte: Progetto Ensembles

E’ da notare che lo spostamento “in solido” della funzione di distribuzione implica non solo un cambiamento dei valori medi ma anche una maggiore probabilità di occorrenza dei valori estremi. Per essere ancora più chiari: se un’anomalia uguale o superiore a 2 gradi potrebbe avere più o meno un 50% di probabilità di accadere nel trentennio 2021-2050, la stessa anomalia potrebbe avere una probabilità superiore al 90% di accadere nell’ultimo trentennio 2071-2100 (la curva “rossa” è infatti quasi tutta a destra del valore di 2 gradi centigradi).

Parallelamente, se periodi molto caldi (ad esempio con anomalie positive di 4-5 gradi) sarebbero ancora giudicati come eventi quasi “rari” nel vicino trentennio 2021-2050, gli stessi risulterebbero essere nella norma alla fine del secolo !

.

Bibliografia

van der Linden P., and J.F.B. Mitchell (eds.) 2009: ENSEMBLES: Climate Change and its Impacts: Summary of research and results from the ENSEMBLES project. Met Office Hadley Centre, FitzRoy Road, Exeter EX1 3PB, UK. 160pp.

.

Nota:

le figure e i risultati riprodotti sono stati estratti dal report finale del progetto ENSEMBLES (Progetto Integrato EU-FP6 ENSEMBLES, Contratto n. .505539)

.

Testo di: Carlo Cacciamani

31 responses so far

Interessante.

Ho una domanda per il dott. Cacciamani. A me gli scenari non sembrano preoccupanti, ma molto preoccupanti. L’aumento delle temperature estive è pauroso. No?

Intendete fare qualcosa per farli conoscere al pubblico e ai nostri politici? Perché il rapporto Ensamble non lo vanno a leggere in molti. Io mi sono letta tutto il post ma perché sono in ferie.. altrimenti magari non avevo tempo e mi fermavo a metà.

Bisognerebbe fare capire in modo efficace come stanno le cose. Ci provo: una traduzione per i non addetti non potrebbe essere: con i cambiamenti climatici stiamo rovinando le estati di chi verrà dopo di noi. No? Grazie

Prima di vedere fino a che punto c’è da preoccuparsi mi interesserebbe sapere quali scenari e con quante emissioni di Co2 sono state tenute in considerazione: è stata fatta la media pesata con le probabilità di emissioni di Co2 di tutti gli scenari oppure no?

Quale valore di sensibilità climatica è stata utilizzata ?

Una delle sfide principali raccolte da Ensables mi sembra certamente quella di cercare di regionalizzare gli scenari climatici su una scala temporale dell’ordine di qualche decade.

Mi interessa sempre molto osservare l’evoluzione dei vari scenari climatici sulla regione Alpina. Se gli scenari di temperatura sembrano ormai consolidati, mi sembra che, per quanto riguarda gli scenari di precipitazione in questa specifica area, siamo ancora lontani dal capire perfino se le precipitazioni potrebbero aumentare o diminuire (ed in questo senso non mi sembra che ci siano grandi progressi rispetto agli scenari IPCC 2007).

Certo il problema sulle Alpi sembra ancora piu’ complesso perche’ il versante nord ed il versante sud, essendo spesso soggetti a regimi meteorologici contrastanti (secco da una parte e umido dall’altra) potrebbero a lungo termine avere andamenti delle precipitazioni anche differenti .

Il problema per le Alpi mi sembra rilevante (turismo, agricoltura, difesa del territorio…). Carlo, mi rendo conto che probabilmente sto chiedendo troppo alle capacita’ di risoluzione dei modelli ma.. quanto lontani siamo dal poter ottenere un dettaglio di questo tipo?

Credo che l’informazione essenzale che si ottiene (otterra’?) da questi studi sia l’effetto su scala regionale non tanto del business as usual ma dei possibili scenari di riduzione. Dando per scontata una certa “dose” di adattamento (con i relativi soldi da spendere) e’ bene poter prevedere in anticipo come muoversi. Forse sara’ difficile riuscire a soddisfare il livello di dettaglio che vorrebbe Gabrielli, ma almeno per su scala un po’ piu’ estesa ci si potra’ preparare.

@Solfrizzo

Le proiezioni mostrate seguono, se non vado errato, lo scenario A1B.

La sensibilita’ climatica varia da modello a modello, non ha senso chiedere quale viene usata in un progetto che si chiama ensamble.

Potrebbe essere anche il contrario: sensitività climatica fissa e media pesata con probabilità di tutti gli scenari emissivi di Co2, anzi la cosa che avrebbe ancor più senso sarebbe la media pesata su entrambi i parametri…

@Solfrizzo

la mia non era una supposizione astratta, e’ quanto c’e’ scritto nel report.

@nowayout

non ho capito come hai fatto a scaricare il report che, a quanto si evince, è disponibile solo su richiesta…

final report all’indirizzo http://ensembles-eu.metoffice.com/

& Enrica

Concordo con Lei che bisognerebbe preoccuparsi di più. L’aumento delle temperature stimate per il futuro è grande e la variabilità del segnale da modello a modello abbastanza modesta ed in ogni caso inferiore al segnale di cambiamento. Quanto alle politiche di diffusione: sicuramente il rapporto Ensemble è lungo e lo leggono in pochi; d’altro canto semplificare in poche righe la complessità della problematica non è impresa semplice (almeno non lo è per me…e di questo mi scuso). Ma credo che lei abbia ragione e bisognerà trovare qualche soluzione che al momento non intravedo dietro l’angolo. Ritengo tuttavia che lanciare delle frasi (o “slogan”) ad effetto, anche se forse puo’ attirare l’attenzione di una piu’ vasta massa di persone, alla lunga produca solo “rumore” e polemiche che allontanano dalla discussione dei veri problemi.

& Soffrizzo

A pag. 36 e seguenti del report finale di Ensemble indicato nel post c’è un’ampia descrizione degli scenari usati. Riassumo in 2 righe: sono state fatte due stream di simulazioni: Stream1, scenari A1B, B1 e A2, stream 2: A1B ed in più è stato usato anche un nuovo scenario (E1) con un’ipotesi di stabilizzazione delle emissioni di CO2 a 450ppm. La figura 4.1 a pag. 37 e il testo esemplificano il tutto. Non mi è possibile entrare nel dettaglio di come sono state fatte le simulazioni e come sono state pesate nei GCM e poi nei RCM perché altrimenti mi ci vorrebbero altri 2 post. Si trova tutto nel report comunque.

& Gabrielli

La regione Alpina è praticamente lo spartiacque tra la parte di Europa dove gli scenari di pioggia individuano un aumento (a nord) e quella dove simulano delle diminuzioni (a sud, nel Mediterraneo). Questo ruolo di divisione emerge per altro anche da analisi climatologiche fatte in passato con dati osservati dalle quali si nota una chiara divisione dei regimi pluviometrici tra nord e sud delle Alpi. Questa occorrenza rende più incerte le simulazioni proprio sull’area alpina, che puo’ in qualche modo essere attenuata con l’aumento della risoluzione dei RCMs (adesso siamo a 25 Km.) ma teniamo presente che i RCMs girano innestati negli AOGCM e quindi si portano appresso anche un po’ della loro incertezza. Ci sono degli spazi di miglioramento, in altri termini…

& NoWayOut

Sono anche io della stessa idea. In Ensemble qualche risposta viene data con l’uso di scenari “mitigati” (simulazioni stream 2 scenario E1 (pag. 42 del report). Ma ritengo che la strada sia ancora all’inizio. Tra l’altro questo approccio permette di avere un’idea (almeno in senso probabilistico) dell’esito dell’azione da intraprendere, a mio avviso, e non credo sia cosa da poco.

Grazie Carlo,

stavo leggendomi il report cercando di capire proprio la relazione tra AOGCM e RCM in modo da comprendere se si siano fatti degli avanzamenti significativi nella rappresentazione del territorio oppure se sulle celle regionali pesassero ancora le incertezze delle celle a piu’ ampia scala dei globali, che poi si riflettono sulle variazioni nelle proiezioni al 2100. Quindi se ho capito bene su questo specifico tema si e’ operato un innesto ‘classico’ tra le due scale diverse?

Certo che è strano che ci abbiano pensato solo ora a fare una media ENSEMBLE sui modelli climatici globali: è il modo migliore per togliere l’incertezza sui tanti modelli e parametri…

Mi chiedo se esiste anche qualche Report che illustri e spieghi, anche a livello fisico-matematico, le differenze tra i vari Modelli Climatici Globali esistenti, i processi modellati, le equazioni usate, tanto per chiarire agli ‘scettici’ il livello di sofisticazione modellistica a cui si è giunti…

@Solfrizzo

le differenze sono spiegate nei vari capitoli dei rapporti Ipcc, con rimandi agli articoli originali per gli amanti della matematica…

@Enrica

I politici sono informati come noi, per es. dal Centro euro-mediterraneo per i cambiamenti climatici. E’ il “focal point£ dell’Ipcc, quindi per alcuni che non nominerò fin dopo la Befana, una tana di inetti e/o falsari.

Per gli altri documenti, papers, modelli, software ecc. gratis su http://www.cmcc.it/

E’ anche interdisciplinare sul serio, rif. http://www.climatescienceandpolicy.eu/

@tutti

Buon anno.

@Solfrizzo

Quando gli scettici parlano della limitatezza dei modelli non intendono affatto dire che dentro a questi ci sono una o due equazioni. Infatti, sanno benissimo il livello di complessita’ dei modelli attuali, del problema dell’accoppiamento oceano- atmosfera, e di tutta un’ampia serie di difficolta’ che si e’ dovuto superare, o che si sta cercando di farlo.

L’accusa di limitatezza nella rappresentazione viene dal fatto che ancora dentro ai modelli non ci stanno delle relazioni fondamentali se non in forma ancora piuttosto grezza per il solo e semplice fatto che ancora non sono note delle parametrizzazioni di base (vedi nubi ecc.). Evidentemente molti modelli gia’ contengono delle parametrizzazioni delle nubi, ma gli stessi che le hanno inserite sarebbero molto cauti nel sostenere che rappresentano veramente il mondo reale.

Come riporta correttamente Cacciamani in una sua risposta, il nesting tra la grande scala e la scala locale trascina con se delle incertezze. Il modelling a scala locale inserisce molta piu’ fisica ma rende l’uso del modello problematico (e necessita di molta piu’ conoscenza dei processi).

Il punto degli scettici non e’ sulle certezze, ma sulle incertezze intrinseche nelle attuali parametrizzazioni.

@Teo

L’ approccio è “classico” nel senso che è il GCM che guida il RCM e non c’è un accoppiamento “two way” dove anche il RCM fa feedback sul GCM. Sarebbe troppo oneroso, si fa per il weather forecast in qualche caso ma non per le climate simulation. L’aumento della risoluzione permette di descrivere in maggior dettaglio, ad esempio, l’orografia e quindi di risolvere quei fenomeni che non sarebbero descritti da un GCM a risoluzione maggiore (ad esempio i vari flussi di momento e di energia da e verso l’atmosfera).

Il carattere innovativo di Ensemble è che un RCM è stato usato con più di un GCM che lo guida. In sostanza si è costruita una “matrice” GCM/RCM (la vedi a pag. 52 del report) che mostra gli accoppiamenti GCM/RCM sperimentati. Ad esempio il RCM del Danish Met Office (indicato con DMI Hirham) è stato girato usando come Boundary Conditions il GCM del Max Planck (MPIMET) e quello del CNRs francese. E cosi’ via per gli altri. In tal modo si sono costruiti dei “multi model ensemble” dai quali è stato poi possibile definire le funzioni di distribuzione di probabiltà (PDF) delle diverse grandezze (temperature piogge) e quindi le probabilità di accadimento di certi scenari, scendendo ai dettagli anche delle singole città in certi casi (vedi ad esempio gli scenari probabilistici per Madrid, fig. 6.14 pag. 67). I RCM sono stati “pesati” in modo tale da tener conto della loro capacità di riprodurre:a) i “weather regimes”, b) il segnale termico e pluviometrico a mesoscala, c) la PDF osservata delle piogge, d) gli estremi termici ed e) infine il ciclo annuale della temp. e della precip. La matematica di come è stato fatto questo è descritta a pag. 50 (Combined metrics). In generale un approccio di “ensemble” del genere permette di avere una valutazione quantitativa dell’incertezza che non è estraibile da un solo modello, o almeno non lo è in maniera soddisfacente. (Già per altro fare “l’ensemble mean” (piuttosto che usare un solo modello) aiuta a diminuire l’incertezza, come viene per altro detto in un commento (Lorenzo Fiori)).

@ Georgiatis

Mi sembra allora che questo lavoro di ENSEMBLES dovrebbe certamente far contenti anche gli ‘scettici’ perchè fare un ‘media’ su tutte le varie e diverse parametrizzazioni insite nei vari ‘Modelli Climatici Globali’ vuol dire appunto ridurre l’incertezza intrinseca degli stessi (sicuramente un passo avanti rispetto al passato) come anche ci conferma il Prof.Cacciamani…

Chissà se anche i risultati espressi metteranno d’accordo gli ‘scettici’…

@ Solfrizzo

Ovviamente avendo lo scettico quale motto ‘cosa mi importa se il mondo mi rese glacial…’ non sara’ mai contento. Mi sembra che questo progetto cerchi egregiamente di sopperire ad una mancanza sempre segnalata di intercomparison. Come ci spiega Cacciamani, qui c’e’ anche il valore aggiunto di una valutazione di GCM con RCM che permette di ricostruire una intera gamma di risposte tra una fisica piu’ grossolana con una piu’ di dettaglio. Onestamente mi sembra un ottimo approccio.

Mi viene da porre una domanda: visto il continuo avanzamento delle conoscenze e la sempre maggiore “regionalizzazione” dei modelli climatici, quanto tempo si ritiene necessario affinché l’accuratezza fisica di questi modelli nel replicare la realtà raggiunga un livello, diciamo, del 90% rispetto alla complessità del sistema clima?

Intendo: accanto alle certezze vi sono anche le incertezze, e nuovi studi rivedono anche quelle che erano definite le certezze. Come possiamo sapere se il tutto non sia perfino peggio di quanto i modelli attualmente dipingono? Ad esempio gli ultimi studi hanno portato il soot effecy da 0,4 a 0,9, che mi sembra un salto piuttosto forte, a riprova di come agire e pensare soltanto sulla CO2 si confermi un grosso errore. Se conosco il 50% di un sistema replico il 50% di quel sistema, ma come posso determinare che tipo di influenza ha il restante 50% che non conosco o conosco poco? Cosa succederebbe se in questi modelli si inserissero quelle variabili (molto più complesse da determinare) che da tanti anni un gruppo come quello di Pielke chiede? Cosa succederebbe se in questi modelli si inserissero modelli di sviluppo delle nubi secondo la teoria dell’iride di Lindzen, di cui se non erro nel 2007 un articolo scientifico trovò prime possibili conferme scientifiche?

Sul fatto che il clima stia cambiando non c’è alcun dubbio, e di certo non si si aspettavano conclusioni diverse da modelli ancora più accurati che si basano sulle nostre conoscenze attuali: andrebbero solo capite le cause, e mi pare che l’appiattimento sul ruolo esclusivo della CO2 e dell’uomo sia possibile fonte di una non reale risoluzione nel mitigamento dell’impatto umano sul clima terrestre. Ad esempio, se la bassa troposfera non si riscalda come ci si aspetta (la qual cosa potrebbe essere dovuta ad un motivo che peggiora il sistema, piuttosto che), e se si è concordi nel dire che la causa di questo comportamento è attualmente sconosciuta, come è possibile affermare che basta diminuire la quantità di CO2 emessa per risolvere il problema?

Domande banali immagino alle quali magari è già stata data risposta, ma chi non fa parte di questo mondo è un po’ incapace a trovarla e comprenderla…

# Simone82

In realtà non comprendo bene cosa significhi, nel merito, la sua affermazione: “…replicare la realtà ad un livello del 90% rispetto alla complessità del sistema…”. Stiamo parlando di riproduzione del campo termico ?, di quello pluviometrico?, dei sistemi di circolazione generale (ad esempio, la NAO o el Nino, ecc…) ? Sono cose diverse, la cui difficoltà di riproduzione è pure diversa. Se vuole possiamo discutere un mese intero su queste cose. Se vuole gliene trovo altre di cause di incertezza. Lei pensa che sappiamo tutto della turbolenza in atmosfera ? Le nubi ? La convenzione che produce i temporali ? I processi orografici ? E via così. E’ evidente che si fanno delle approssimazioni, che si modellano dei processi fisici talvolta in maniera brutale, ma ragionevole, con delle leggi talvolta semplificate. E tante altre volte, le diro’, pur sapendo le leggi più complesse, non le possiamo neanche infilare dentro i modelli perchè poi per farli girare non abbiamo i calcolatori che ce la fanno. E allora, stante le incertezze che sappiamo, cosa facciamo, continuiamo a filosofeggiare di metafisica e attendiamo “l’earth model “ perfetto ? Che riproduca il 99% della realtà, pur sapendo che anche questa pretesa è, in realtà, addirittura… difficilmente definibile ?

Mi scusi, ma è veramente fantastico notare come per la scienza del “climate modelling” si usi un accanimento di critica che non ha eguali nel resto della scienza. Le chiedo: forse sappiamo bene, ma proprio bene, le ragioni intime per cui si trasmettono le malattie, oppure perchè crescono le piante e gli animali ? E sappiamo proprio con certezza come è nato l’Universo ? Eppure esiste la botanica, la genetica, e la medicina li cura si o no i malati nonostante le milioni di cose che non si sanno di medicina ?

E’ poi evidente, mi permetta, che i modelli si fanno con le leggi che si conoscono, faccio fatica a pensare come si possano fare dei modelli con delle leggi che non si…conoscono (ma che in realtà si ipotizza che possano esistere, lei dice. E io le rispondo: non è questa metafisica pura ?).

In conclusione, accettiamo da tutte le parti l’incertezza e ci conviviamo tutti i giorni e con le incertezze ci costruiamo le nostra vite di poveri uomini mortali pero’, accidenti, sul climate modelling no, li bisogna attendere il modello perfetto. Si rende conto di quanto sia assurda questa pretesa ?

L’ho già scritto ma il problema va visto da un punto di vista più pragmatico, secondo me, che si applica per altro da tutte le parti, sempre e da sempre, e quindi si deve applicare anche nel climate modelling senza pensare che questo non sia fare della scienza. L’assunto è: dato il livello di incertezza, migliorabile finchè si vuole, ci sono comunque delle cose abbastanza sicure sulla scienza del climate change. Alcune le ho citate nel post. Ad esempio che farà un caldo della malora nelle prossime estati mediterranee. E, stante queste (poche) certezze o anche (quasi) certezze, è possibile fare delle azioni per minimizzare i danni. Queste cose si chiamano “adattamento”e “mitigazione”. E bisogna muoversi a farle.

@cacciamani

se non mi sai dire cosa ha fatto anche una minuscola frazione degli elettroni che ti hanno permesso di scrivere questo post e di farlo leggere a noi, come faccio a sapere che hai scritto propio cio’ che io sto leggendo? Ergo, che hai scritto a fare? 😀

Scherzi a parte, concordo pienamente con quanto hai detto. Battere il chiodo delle incertezze (per altro mai negate da nessuno e, nei limiti del possibile, considerate) e’ assolutamente specioso. Diro’ di piu’, senza voler sottovalutare gli enormi progressi che sono stati fatti e che si continuano a fare, alla fin fine il grosso del problema e la sua valutazione quantitiva non e’ che sia cambiata granche’ da Arrhenius a oggi. Ad esempio, la gran parte delle sensibilita’ climatiche stimate con i metodi piu’ svariati rientra nel range dell’AR4 (Arrhenius e’ fuori, ma mica poi di tanto); lo stesso si puo’ dire per l’effetto di amplificazione ai poli.

Quindi cosa e’ che si va cercando oggi? I dettagli. E qui, se ben intendo, entra il tentativo di superare le limitazione dei GCM “classici” con il progetto ENSEMBLES.

Congrats.

@ Cacciamani

Carlo d’accordissimo.

Pero’ non c’e’ persecuzione nei confronti della modellistica. Sarebbe semplicemente stupido. L’insistenza sui limiti dei modelli nasce per il fatto che qualcuno poi prenda i risultati dei modelli dimenticandosi le incertezze e del modello e dei dati che lo alimentano. Come al solito tu dimostri una grande onesta’ scientifica quando nelle tue esposizioni o risposte sei il primo a sottolineare questi limiti.

@NoWayOut

La mania dei nuovi modelli, non la capisco nemmeno io. Puro consumismo. Da 35 anni uso il Manabe-Wetherald e funziona ancora benissimo, guarda:

http://www.bom.gov.au/announcements/media_releases/climate/change/20100105.shtml

Scherzi a parte, non è che uno dei climalteranti farebbe un post su grandi classici? Dò la ref. del mio, non si sa ma: Manabe S., Wetherald R., 1975, The Effects of Doubling the CO2 Concentration eccetera, J. Atmos. Sci., vol 32, pp 3–15.

@ cacciamani

Sono un dottorando in archeologia, le posso assicurare che quanto ad accanimento, noi scienziati umanisti siamo campioni assoluti, quindi può stare tranquillo, la scienza del climate modeling può stare al sicuro da questo punto di vista. Diciamo soltanto che la pretesa di regolare la vita di miliardi di persone e di spendere il loro denaro secondo modelli che nella migliore delle ipotesi sono approssimati alla bene meglio (sempre scientificamente basati, natürlich), questo sì fa scientificamente arrabbiare molte persone.

Mi sembra che la risposta del dott. Teodoro sia perfettamente esplicativa di quello che è il mio pensiero: d’altronde, leggo questo articolo

Wang, Y., C.N. Long, L.R. Leung, J. Dudhia, S.A. McFarlane, J.H. Mather, S.J. Ghan, and X. Liu. 2009. “Evaluating Regional Cloud-Permitting Simulations of the WRF Model for the Tropical Warm Pool International Cloud Experiment (TWP-ICE), Darwin, 2006.” J. Geophys. Res., 114, D21203, doi:10.1029/2009JD012729

e mi chiedo: da dove deriva l’assoluta certezza con la quale si organizzano convenzioni politiche tipo COP15? Da dove deriva l’assoluta certezza con la quale i cambioclimatisti hanno già dipinto la tela del futuro clima terrestre? Deriva da questi modelli pieni di incertezze, simulazioni “brutali”, mancate conoscenze? Per carità, sono perfettamente sicuro che tutto ciò che noi conosciamo sul clima venga perfettamente riprodotto da questi modelli, non sono uno che dice che i dati vengono artefatti per far uscire il risultato voluto: ma come chiesi altrove, se noi togliamo la variante antropica a questi modelli, essi dovrebbero essere in grado di riprodurre l’evoluzione climatica pre-1750. Se questo, come è, non avviene, con quale grado di sicurezza basiamo le nostre politiche sui risultati di questi modelli? Perché cioè si focalizza l’attenzione su di loro e sulla CO2 e non su tanti altri fattori come il land modeling, il soot effect, ed altre componenti? Potrebbe essere che la situazione è più grave del previsto, e che il solo agire sulla CO2 non produca i risultati voluti? Imho, potrebbe anche essere…

È ragionevole pensare che, non dico Al Gore o GreenPeace, non dico lei che dimostra mi pare grande equilibrio, la scienza cambioclimatista affronti il dibattito in maniera più seria e più tranquilla? La cattiveria di certi scienziati deriva dalla cattivera con la quale quelli del CRU sembrano voler imporre a tutti i costi la loro visione (che è quello che risulta dalle email rubate, in maniera oggettiva e senza tema di smentita, ancorché senza alterare i dati) come l’unica giusta e fedele alla realtà. E allora, perché se c’è un tranquillo dibattito scientifico sulla ricerca sul clima, poi questo dibattito diventa avvelenato quando questa ricerca confluisce nei modelli? Forse perché poi, la stasi climatica attuale potrebbe cambiare il trend del clima, e siccome questa stasi non è stata prevista e non se ne conoscono gli effetti e la fine, poi anche i modelli potrebbero dover finire al macero? Se i modelli sono così puntuali come si vuole affermare, mi pare abbiano fallito*: se non sono così puntuali, allora tutto è nella norma, e si continua a lavorare nella ricerca come prima. Magari al prossimo rapporto IPCC del 2013 vedremo nuovi modelli calcolati sulla base della nuova realtà attuale, che non siamo stati in grado di prevedere e che non sappiamo da cosa è determinata (la crescita delle temperature non è lineare con la CO2, ergo), non sappiamo quando finirà e che effetti produce sul sistema clima.

Quello che dico sarà anche specioso, ma io non ho da difendere alcunché poiché non faccio parte di questo mondo: ergo non mi sembra di dire cose antiscientifiche (a meno che non si voglia ributtare nella discussione la storia che all’IPCC sono bravi e buoni, mentre al WUWT sono brutti e cattivi), ergo guardo sempre con molto piacere a questi progetti che tendono ad andare sempre più in profondità al problema. Cmq non si preoccupi, una diecina d’anni e con il gpu-computing ed il progetto Tera-Scale di Intel ne avrete di potenza di calcolo a disposizione… 😀

La ringrazio di aver speso del tempo prezioso per rispondere ai miei dubbi profani.

*= puro ragionamento matematico. Se nel 2010 si doveva essere a 2 per arrivare a 3 nel 2020 (con una crescita lineare), secondo i modelli, se nel 2010 sono a 1,7 significa che per arrivare a 3 nel 2020 impiego non più 1 ma 1,3, il trend non è più lineare ed il riscaldamento del prossimo decennio dovrà essere più forte di quanto i modelli abbiano previsto. Ergo, i modelli non hanno replicato correttamente la realtà: tutti danno un trend lineare, di quelli confluiti nell’IPCC 2007, il che significa che in base alla realtà attuale il trend non sarà lineare. Se sarà lineare, il punto di arrivo sarà inferiore a quello previsto, se il punto di arrivo fosse lo stesso, il trend è in crescita più forte di quella prevista. Ciò signifia che essi sono pienamente e correttamente rispondenti ai nostri dati ed alle nostre leggi, ma esse non bastano per simulare il clima ad un livello di fedeltà che possa definirsi accettabile: quando parlo di fedeltà al 90% parlo di questo. Il problema non è una deviazione di 0,1x°, che rende il modello comunque valido, il problema è sapere se questa deviazione è più grande o più piccola.

PS: Mi scuso per il post estremamente lungo, ma purtroppo su questi temi non ho il dono della sintesi e per farmi capire mi tocca essere prolisso.

@simone82

Non è corretto dire che i modelli IPCC 2007 mostrano un trend lineare ed hanno fallito a riprodurre la realtà, l’andamento quasi lineare è la media ensemble dei modelli, le singole realizzazioni hanno andamenti tutt’altro che lineari e a volte mostrano brevi fasi di calo a volte accelerazioni in conseguenza della variabilità naturale; il mondo reale non è una media ensemble ma un singolo spago percui non è sorprendente se nel mondo reale si osserva un’andamento non lineare delle temperature:

http://www.realclimate.org/images/runs.jpg

@Simone82

Non voglio ribattere oltre, non per scortesia mi creda, ma perché in gran parte ripeterei quanto già detto e rischierei solo di essere prolisso. Però una domanda non riesco a non fargliela, visto che parla anche di denaro…: “E se questi modelli così “approssimati” dicessero delle cose anche solo…abbastanza giuste, come io ritengo che sia, e sufficienti comunque per suggerire di intraprendere urgentemente delle azioni di adattamento e/o mitigazione, e che il non prenderle potrebbe determinare un danno potenziale, ebbene, lei ha un’idea di quanto grande sarebbe il danno connesso alla “non azione” ? (Dia un occhio anche a:

http://www.e3network.org/opeds/Ackerman_testimony_April22.pdf

è solo un esempio, ce ne sono molti altri di studi del genere)

Non ritiene che, se puta caso andassero così le cose, magari si potrebbero arrabbiare (e non solo scientificamente…) i nostri nipotini ?

@ gp

La ringrazio del chiarimento e prendo atto di aver utilizzato termini sbagliati. Tuttavia l’immagine che lei mi mostra rafforza quanto ho precedentemente espresso: i modelli hanno previsto una crescita per il decennio 2000-2010 di 0,2 °C ca. Se noi prendiamo la fine di quel grafico posto a 0,6 °C nel 2020, debbo dedurre dall’osservazione della realtà che di fatto nel 2020, ammettendo che la previsione del prossimo decennio sia corretta, ci troveremo non a +0,6 °C rispetto al 1990 ma a +0,4 °C. Ergo al termine del trend nel 2100, sempre ammettendo che i prossimi 9 decenni siano calcolati correttamente, non ci troveremo a +2 °C ma a +1,8 °C. Questa è matematica: se ciò che ha causato questa stasi climatica è sconosciuta, vuol dire che le nostre conoscenze scientifiche sono ancora scarse, e se sono scarse allora sono scarse le variabili di calcolo inserite nei modelli, ergo i modelli sono scarsi (scusate se utilizzo un sillogismo, ma mi pare ovvio). Se i modelli sono scarsi, utilizzarli come il vangelo ogni volta che si parla di AGW (non qui sopra ma in generale, soprattutto dagli ambientalisti) non è scienza: e purtroppo molto pochi sono puntuali e precisi come il dott. Cacciamani a ricordare quali sono i problemi ancora irrisolti di questi modelli. Non significa che siano sbagliati, non l’ho mai affermato: si tratta solo di dire a tutti qual’è la realtà e come stanno realmente le cose, cosa che purtroppo non viene fatta.

@ cacciamani

Mi perdoni, dove ha letto che io parlerei di “non azione”? Roger Pielke non parla di “non azione”, parla di un’azione molto più vasta e più complessa da mettere in atto, cosa che non si sta facendo: allora sono io a chiederle se è giusto che di fronte a modelli approssimati si parli solo e sempre di CO2. La mia risposta è: la CO2 produce denaro, mentre il resto delle politiche di affronto del problema della mitigazione dell’impatto umano sul clima e sulla terra in generale non producono questi grossi spostamenti di denaro. Non vorrei essere prolisso, ma sono perfettamente in grado, per formazione culturale ed approccio scientifico e metodologico che mi viene sempre riconosciuto, di riconoscere difese accademiche e difese scientifiche. Non vorrei risultare offensivo perché non è così, ma molti post sui modelli (anche su questo blog) mi paiono più rivolti alla difesa accademica del loro uso che alla difesa scientifica del loro uso. Almeno lei ha avuto la bontà di sottolineare le criticità ancora esistenti, in questo sono d’accordo con Teodoro.

Cmq la ringrazio del tempo speso perché sono estremamente interessanti e portano alla luce un progetto che a mio avviso non può che avere un impatto molto importante per gli studi futuri sul sistema clima.

Simone82,

va bene l’incapacita’ di sintesi, ma almeno le affermazioni si capisca a cosa o a chi si riferiscono.

Esempio: “si parli solo e sempre di CO2”. A cosa o chi ti riferisci? L’affermazione buttata li’, cosi’, e’ di una genericita’ sconcertante.

Altro esempio: “la CO2 produce denaro, mentre il resto delle politiche di affronto del problema della mitigazione dell’impatto umano sul clima e sulla terra in generale non producono questi grossi spostamenti di denaro”. A che interventi ti riferisci e proposti da chi? E con quali obiettivi? E sono mutuamente esclusivi? E se non lo sono, con quale bilancio fra i due?

Altro esempio: “se noi togliamo la variante antropica a questi modelli, essi dovrebbero essere in grado di riprodurre l’evoluzione climatica pre-1750. Se questo, come è, non avviene”. Chi o cosa non e’ in grado di riprodurre i climi del passato? E riprodurre in che senso? Al 90%, magica soglia per anche solo prendere in considerazione qualcosa?

Non continuo e per carita’ sorvolo sulle pseudo-estrapolazioni “scientifiche” che fai. Ma anzicche’ piccarti di essere (l’unico?) “perfettamente in grado, per formazione culturale ed approccio scientifico e metodologico che mi viene sempre riconosciuto, di riconoscere difese accademiche e difese scientifiche”, dove sta la tua difesa scientifica? E dove la difesa accademica? Oppure, come speso fai, credi di essere nel tuo blog e non parli di cio’ che si dice qui, degli interventi delle persone in questo blog, ma sull’idea generale che ti sei fatto del mondo dei sostenitori dell’AGW? Giusto per saperlo, se cosi’ fosse non mi sentiro’ coinvolto nelle tue declamazioni e non mi prendero’ la briga di rispondere visto che parli di altri.

Simone82 credo che non ci siamo capiti, la linea nera nell’immagine mostra l’andamento della media ensemble; il mondo reale non è una media ensemble ma una singola realizzazione ovvero un singolo spago di quelli presenti nell’immagine i cui andamenti su 10 anni non sono tutti in aumento di 0.2°C poichè nel mondo reale la somma del trend forzato +la variabilità naturale a volte smorza a volte esaspera il trend di fondo….se si vuole capire quale di quegli spaghi si realizzerà nel mondo reale occore far riferimento ai modelli di previsione decennale come quello del Metoffice(Smith et al.) di cui nel report finale del progetto ensemble è disponibile una verifica(Figura 3.7), e questo modello finora è riuscito a descrivere dignitosamente sia l’andamento delle temperature globali che la distribuzione delle anomalie su scala temporale decennale.

http://img94.imageshack.us/img94/1530/decadalgraphic.gif

[…] visto nel post precedente, i lavori del progetto ENSEMBLES forniscono proiezioni sul clima europeo del futuro molto […]

[…] Quanto all’affidabilità dei AOGCMs , è un dato di fatto invece che gli strumenti di simulazione del clima dell’ultima generazione abbiamo fatto dei progressi considerevoli e diminuito in maniera evidente i loro margini di errore. Ad esempio in IPCC AR4 (cap.8) vengono confrontate le performances dei GCMs antecedenti l’anno 2000 con quelli disponibili già solo 5 anni dopo nel riprodurre il clima attuale e si nota in maniera evidente come, ad esempio, gli errori di riproduzione dei campi medi al suolo di temperatura, pressione atmosferica al suolo e precipitazione siano notevolmente diminuiti, pur con i margini di incertezza che sono per altro dichiarati in maniera molto precisa e con il massimo della trasparenza. Peraltro, anche la gestione di tale incertezza è stata affrontata, anche qui la Scienza non è all’anno zero. Ed anche con diversi approcci: uno di questi metodi è l’uso delle tecniche di Ensemble di cui si è parlato diffusamente anche su altri post di climalteranti (vedi qui). […]

[…] climatico degli estremi in Europa (pag. 178). Si è già discusso degli scenari regionali in Europa in un altro post e si è mostrato anche come l’incertezza associata a tali scenari in tale area del Pianeta sia in […]