Temperature 2010: un altro anno caldo in zona record

Le prime valutazioni sulle temperature medie globali rilevate nel 2010 mostrano che, nonostante le ripetute irruzioni di aria artica che hanno caratterizzato l’inizio e la fine dell’anno, il 2010 dovrebbe collocarsi in seconda posizione nella graduatoria degli anni più caldi, con una piccola differenza rispetto alla prima posizione, inferiore all’errore della media. Il maggiore contributo al riscaldamento è venuto dalle zone più fredde della Terra, l’Artide e l’Antartide, in sintonia con le previsioni dei modelli, mentre le medie latitudini hanno evidenziato temperature nella norma o addirittura lievemente inferiori ad essa, il che non aiuta i media a trasmettere una immagine completa dei fenomeni. Inutile sottolineare, ancora una volta, come i dati smentiscano coloro che, puntualmente, dopo ogni irruzione fredda, paventano imminenti ere glaciali in agguato.

.

Smaltita la sbornia di Capodanno, eccoci pronti a effettuare le prime statistiche termometriche sull’anno appena trascorso. Nel nostro emisfero, l’anno termina d’inverno, e quindi è normale parlare di temperature medie in un periodo dell’anno in cui, normalmente, fa freddo. Semmai, può essere singolare parlare di riscaldamento globale in un periodo dell’anno in cui sono ricorrenti le irruzioni di aria artica, che proprio calda non è. Tuttavia, le misure hanno il vantaggio di essere neutrali e scevre da impressioni personali.

Come mia abitudine, per un commento immediato all’anno appena trascorso, mi ispiro alla fonte di dati immediatamente disponibile, e cioè quello del NCEP/NCAR [National Centers For Environmental Prediction’s and National Center for Atmospheric Research], che distribuisce gratuitamente, e con soli due giorni di ritardo, un notevole numero di dati utilissimi (tra cui le temperature in atmosfera), mediati su un grigliato di 2,5 gradi in longitudine e latitudine (alle nostre latitudini, significa circa 300 x 300 km quadrati). Si tratta di dati elaborati e non grezzi, il che permette la loro disponibilità con alcuni giorni di anticipo rispetto alle medie ottenute dall’analisi diretta dei dati delle stazioni, che debbono invece essere prima controllati, e consentono, quindi, una rapida analisi preliminare dell’anno appena trascorso.

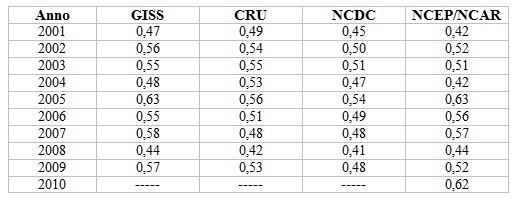

La tabella sottostante mette a confronto la serie degli ultimi 10 anni dei dati NCEP/NCAR, opportunamente mediati sul globo terrestre, con quelli dei siti “ufficiali” (GISS [Goddard Institute for Space Studies, NASA], CRU [Climatic Research Unit, University of East Anglia] e NCDC [National Climatic Data Center, NOAA]), che usano algoritmi leggermente diversi per calcolare le medie sulla griglia a partire dai dati delle stazioni. Il valore medio ottenuto con i dati NCEP/NCAR per il 2010 è di 0,62°C, dato che lo colloca in seconda posizione rispetto al 2005, a soli 0,01°C di distanza. Poiché l’errore sulla media, fornito dai vari centri, è dell’ordine di 0,01-0,02°C – per questo motivo ho mantenuto i due decimali significativi nel dato – e probabilmente anche maggiore per i dati NCEP/NCAR, che sono analisi e non dati diretti, tali valori possono essere considerati praticamente coincidenti.

Valori di temperatura media globale nel periodo 2001-2010 secondo i dataset GISS, CRU, NCDC e NCEP/NCAR, espressi come anomalia rispetto al periodo di riferimento 1961-90. I numeri dell’ultima colonna sono stati ottenuti mediante una media globale dei valori medi annui.

.

Personalmente, non ritengo importante appurare esattamente dove si collocherà il 2010 nella classifica degli anni più caldi. Preferisco invece notare, e sottolineare, il fatto che, con ottima verosimiglianza, per usare un linguaggio sportivo, il 2010 dovrebbe porsi per lo meno “in zona medaglia”; il 2010 allunga la successione di anni con temperature superiori alla media che caratterizzano l’antropocene, e questo nonostante l’Oscillazione Nord Atlantica (NAO) abbia avuto valori estremamente negativi ed il Sole sia ancora in una fase di minimo.

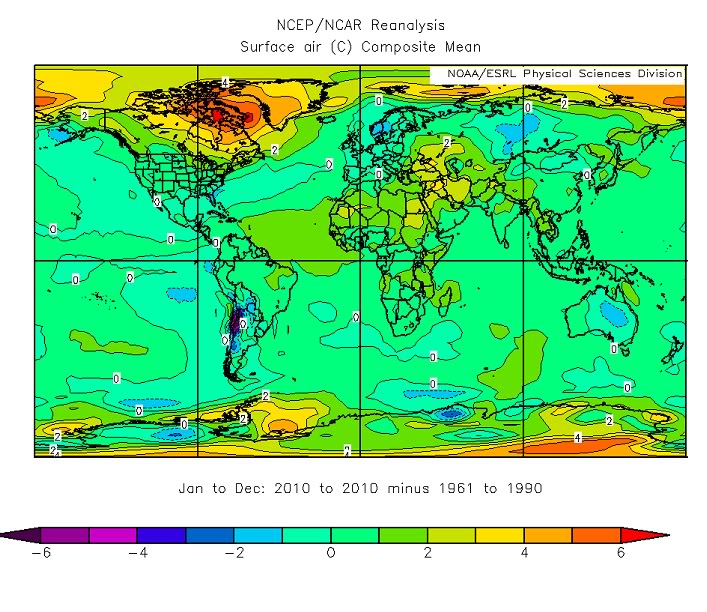

Guardando l’immagine della distribuzione delle anomalie di temperatura nel 2010, si nota subito come le regioni polari siano state caratterizzate da vistose anomalie positive, spesso superiori a 4°C, con un picco di oltre 6°C tra il Canada orientale e la Groenlandia. Un’analisi più attenta mostra tuttavia che molte altre regioni del globo sono caratterizzate da anomalie positive, a partire dall’ampia fascia che parte dal Brasile e si estende a gran parte dell’Atlantico fino a metà del Pacifico, in entrambi gli emisferi (con picchi superiori a 3°C). Le anomalie negative, in genere con valori modesti, sono limitate a parte dell’Australia, una ristretta zona dell’Antartide e dell’oceano circumantartico, parte del Pacifico, il golfo del Messico, parte della Siberia, e l’Europa nordoccidentale.

Anomalia di temperatura superficiale nel mondo relativa al 2010 rispetto al periodo di riferimento 1961-1990. Grafico generato dalle informazioni NCEP/NCAR.

.

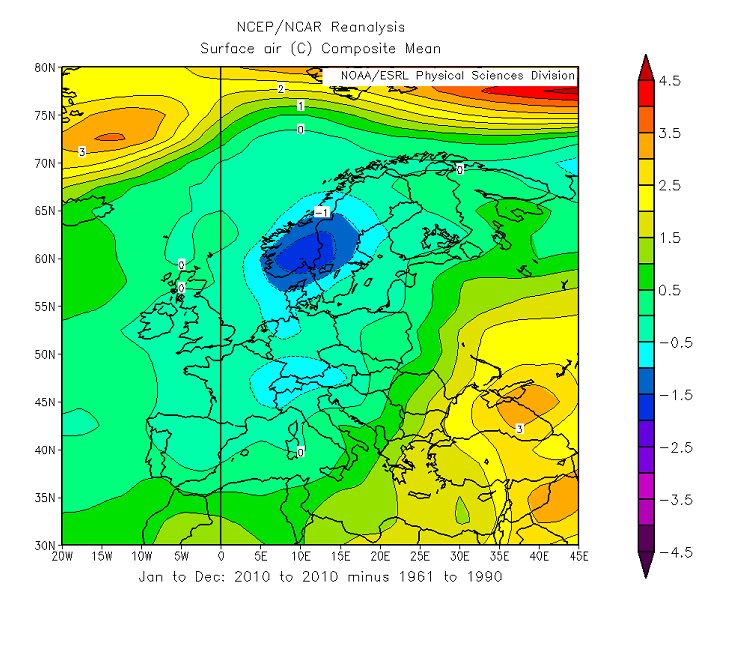

Uno zoom relativo all’Europa mostra infatti un’ampia fascia di valori negativi di anomalia estesi dalla Scandinavia fino a tagliare a metà Spagna ed Italia, piccati sulla Norvegia (-1,5°C), circondata da valori di anomalia positivi che, sul Mar Nero e sull’estremo Mediterraneo orientale, arrivano a +3°C.

Anomalia di temperatura superficiale sull’Europa relativa al 2010 rispetto al periodo di riferimento 1961-1990. Grafico generato dalle informazioni NCEP/NCAR.

.

Da notare che risultati del tutto analoghi si ritrovano anche graficando la mappa delle temperature alla quota di 850 hPa (più o meno corrispondente a 1500 m di altezza), ovvero approssimativamente la sommità dello strato limite planetario, a riprova del fatto che i valori mostrati sono caratteristici delle proprietà dell’atmosfera e non dipendono da proprietà locali.

.

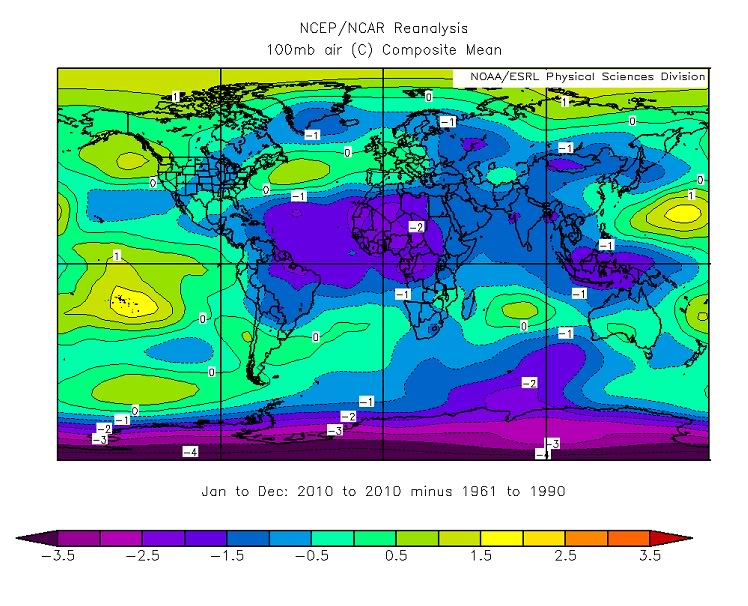

Se si esamina la mappa analoga relativa alla temperatura a 100 hPa (ovvero a circa 31 km di altitudine), in piena stratosfera, si vede che il discorso cambia drasticamente, e tendono a prevalere le anomalie negative, soprattutto nella fascia tropicale-equatoriale e sul polo Sud. Il fatto che le temperature superficiali mostrino anomalie positive e quelle stratosferiche invece anomalie negative è una delle conseguenze attese dell’incremento dell’effetto serra (si veda ad esempio qui).

Anomalia di temperatura a 100 hPa nel mondo relativa al 2010 rispetto al periodo di riferimento 1961-1990. Grafico generato dalle informazioni NCEP/NCAR.

.

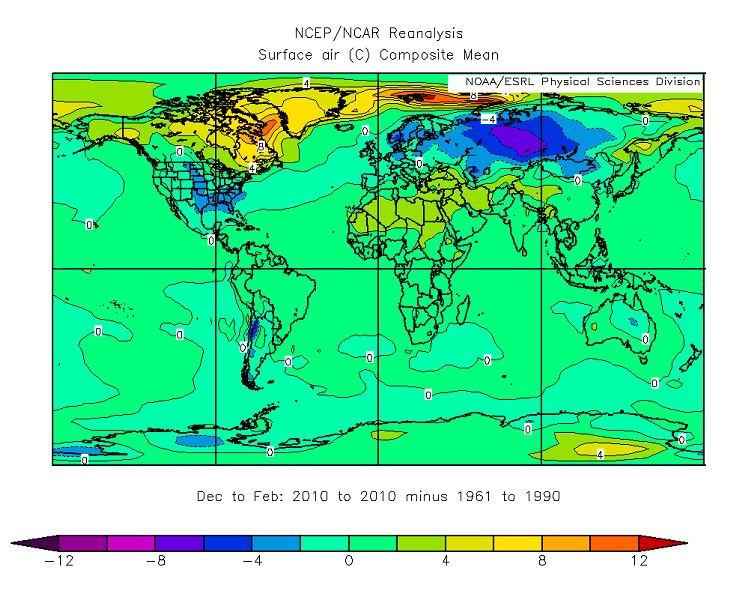

Vediamo ora la successione delle mappe stagionali, partendo dallo scorso inverno. Troviamo qui un’ampia fascia che circonda tutto il polo Nord e, tra Canada e Groenlandia, si estende fino alle medie latitudini, caratterizzata da temperature marcatamente positive, con un massimo di +12°C al largo della Baia di Baffin. Ad essa si contrappone, sul meridiano opposto ma circa alla stessa latitudine, un’area di anomalie negative, con un minimo di -6°C circa sulla Mongolia. L’isolinea 0°C nell’emisfero nord delimita una stretta fascia di anomalie negative appoggiata ai tropici che dal minimo si estende verso ovest ricoprendo l’Atlantico, gli USA ed il Messico. Nell’emisfero sud i gradienti sono più modesti e praticamente si compensano, mentre parte dell’Antartide mostra un picco di oltre 4°C.

Anomalia di temperatura superficiale nel mondo relativa al periodo dicembre 2009 – febbraio 2010 rispetto al periodo di riferimento 1961-1990. Grafico generato dalle informazioni NCEP/NCAR.

.

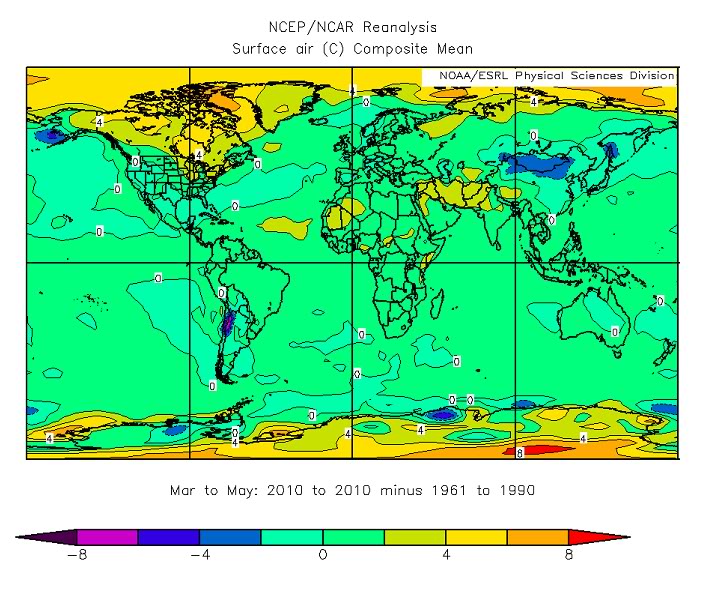

La primavera presenta nuovamente anomalie molto elevate nelle zone polari, con massimi di 6°C nei pressi della Groenlandia e di oltre 8°C in Antartide, valori elevati anche sull’Atlantico tropicale, sull’Africa e sull’Asia meridionale, ed un’ampia fascia di anomalie negative estesa tra l’Asia orientale e l’America settentrionale tra 10°N e 60°N di latitudine.

Anomalia di temperatura superficiale nel mondo relativa al periodo marzo – maggio 2010 rispetto al periodo di riferimento 1961-1990. Grafico generato dalle informazioni NCEP/NCAR.

.

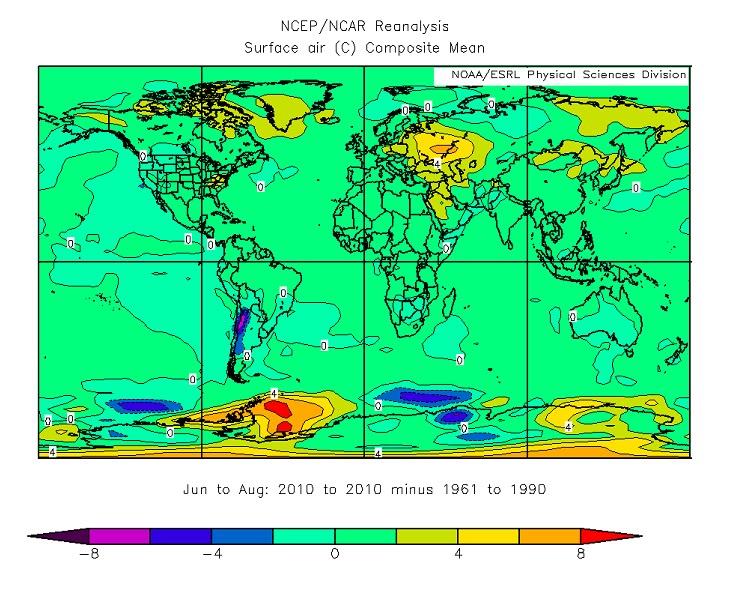

La mappa delle anomalie estive presenta ancora un massimo relativo (2°C) sulla Groenlandia, parte di una fascia di anomalie positive che circonda il globo nell’emisfero nord e culmina con un valore di oltre 6°C sulla Russia (sullo stesso territorio flagellato dai terribili incendi che hanno riempito i notiziari estivi). Nell’emisfero Nord, le anomalie negative sono sporadiche con minimi modesti, e nell’emisfero sud raggiungono i -4°C soltanto in alcune ristrette zone dell’Antartide, ma sono più che compensate da ampie fasce di anomalia positiva nei pressi della penisola antartica, con massimi di oltre 8°C, e dalla fascia di 6°C proprio sul polo sud.

Anomalia di temperatura superficiale nel mondo relativa al periodo giugno – agosto 2010 rispetto al periodo di riferimento 1961-1990. Grafico generato dalle informazioni NCEP/NCAR.

.

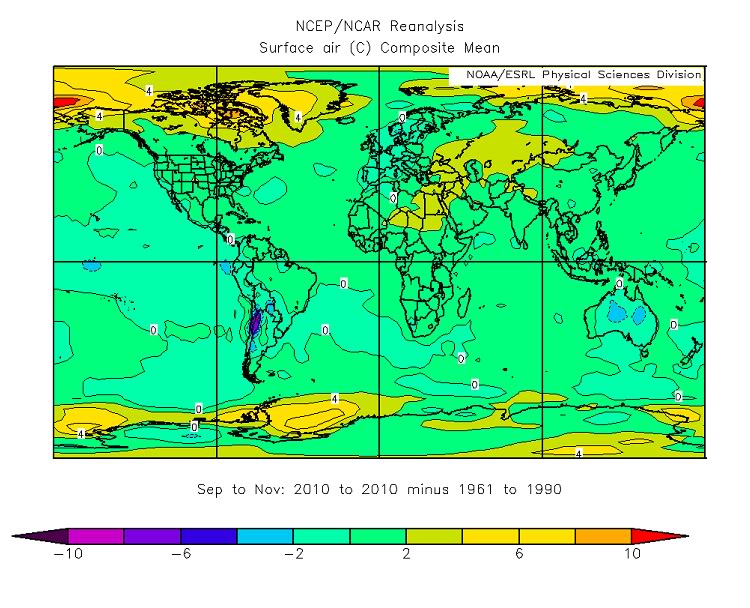

Infine, l’autunno torna nuovamente a presentare entrambe le zone polari sotto anomalie positive anche ragguardevoli, con oltre +10°C nei pressi dello stretto di Bering e diversi massimi a oltre 6°C anche sull’Antartide. Nell’emisfero Nord, praticamente tutti i continenti, tranne l’Europa occidentale, si trovano sotto anomalie positive superiori a +2°C, mentre nell’emisfero Sud i continenti, tranne l’Africa, mostrano anomalie prevalentemente negative. L’Atlantico è ricoperto da anomalie più positive che negative a nord, e più negative che positive a sud, mentre il Pacifico mostra anomalie prevalentemente negative nella parte centrorientale e leggermente positive a ovest, e l’Indiano valori positivi.

Anomalia di temperatura superficiale nel mondo relativa al periodo settembre – novembre 2010 rispetto al periodo di riferimento 1961-1990. Grafico generato dalle informazioni NCEP/NCAR.

.

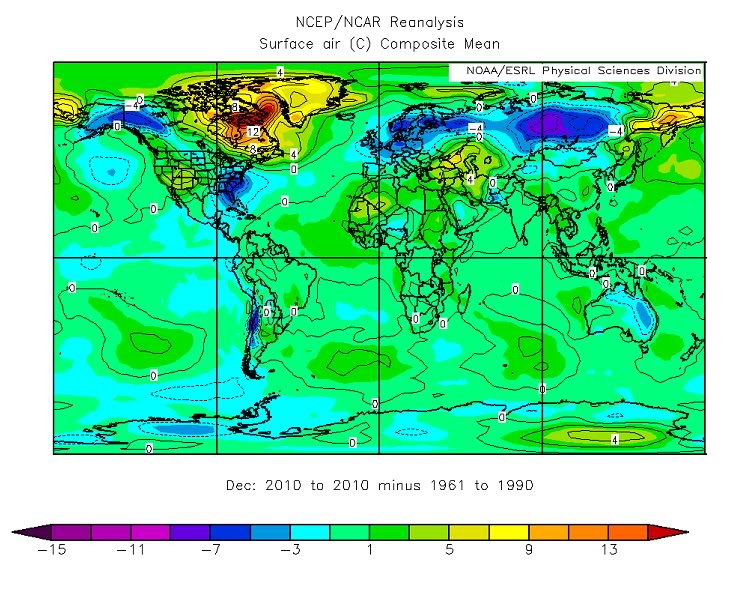

Le medie del mese di dicembre 2010 mostrano i valori estremi nella fascia di latitudini comprese tra il tropico del Cancro ed il polo Nord. Un massimo spaventoso di oltre 15°C campeggia ancora tra Canada e Groenlandia, e ad esso si accompagnano un altro massimo di oltre 9°C sull’estrema Siberia orientale ed un massimo secondario (6°C) tra il mar Nero ed il mar Caspio. Tra i massimi, un minimo secondario (-3°C) si trova nei pressi dell’Alaska, ed un’ampia zona di anomalie negative, con un minimo inferiore a -6°C esteso tra Siberia e Cina, ricopre gran parte dell’Eurasia. L’isolinea 0°C delimita abbastanza nettamente due zone, con un andamento abbastanza ondulato, nell’emisfero Nord: quella inferiore, caratterizzata da anomalie debolmente negative, avvolge praticamente l’intera Europa e gran parte dell’Asia, nonché una porzione di America settentrionale.

Anomalia di temperatura superficiale nel mondo relativa al mese di dicembre 2010 rispetto al periodo di riferimento 1961-1990. Grafico generato dalle informazioni NCEP/NCAR.

.

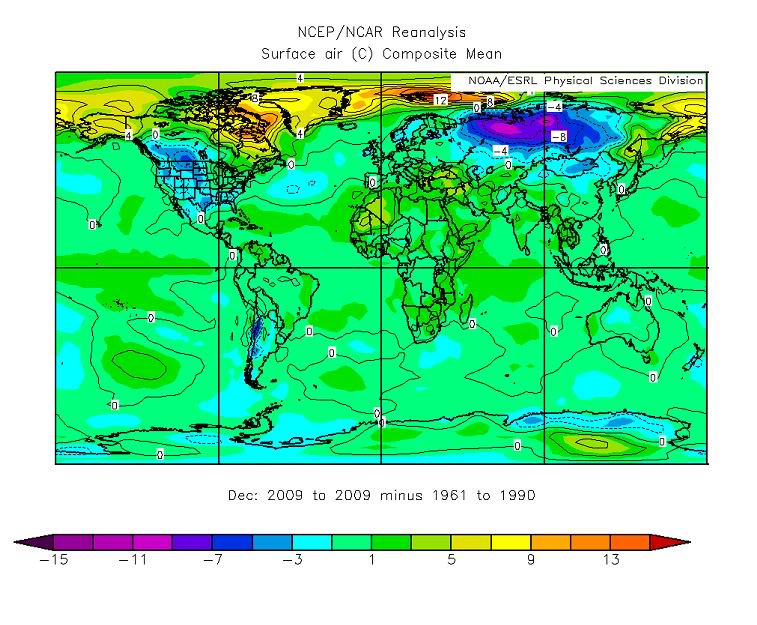

Tale mappa, a prima vista, parrebbe avere qualche somiglianza con quella relativa al mese di dicembre 2009, mostrata qui sotto a scopo di paragone. In particolare, il massimo ed il minimo assoluti sono collocati nella stessa posizione, cioè tra Canada e Groenlandia e sulla Siberia, rispettivamente. In realtà, un’analisi più accurata rivela diverse caratteristiche salienti molto distinte: nel dicembre 2009, l’intera zona sopra i 70°N di latitudine mostrava valori molto elevati di anomalia, e gran parte del Nordamerica era avvolto da un’anomalia molto negativa. Inoltre, anche i valori numerici sono differenti.

Anomalia di temperatura superficiale nel mondo relativa al mese di dicembre 2009 rispetto al periodo di riferimento 1961-1990. Grafico generato dalle informazioni NCEP/NCAR.

.

Tuttavia, queste mappe suggeriscono anche un criterio di interpretazione. Negli ultimi due inverni (in realtà, in ogni mese dell’anno), le anomalie di temperatura sono risultate globalmente positive, ma la loro distribuzione spaziale è stata peculiare: i massimi più vistosi hanno riguardato aree poco abitate, o comunque zone molto fredde, nelle quali anche diversi gradi di aumento non facevano notizia più di tanto. Al contrario, i minimi, pur essendo numericamente (in valore assoluto) sempre inferiori ai massimi, hanno caratterizzato spesso regioni del mondo densamente popolate ed altamente tecnologiche, creando diversi disagi, danni e, purtroppo, anche perdite di vite umane, che sicuramente hanno fatto più notizia.

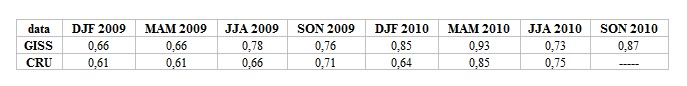

A questo proposito, vorrei terminare l’analisi mostrando una tabella in cui sono riportate le medie stagionali delle temperature globali secondo due dei centri climatici internazionali più accreditati. Sorpresa: l’inverno 2009-2010 non si presenta per nulla come freddo, anzi per entrambi i centri è risultato più caldo di quello precedente, e per il GISS è addirittura il secondo inverno più caldo di sempre, dopo il 2006-7, a riprova di quanto detto sopra.

Anomalia di temperatura superficiale nel mondo relativa alle stagioni dal 2009 al 2010 (DJF=inverno, MAM=primavera, JJA=estate, SON=autunno) rispetto al periodo di riferimento 1961-1990.

.

Testo di: Claudio Cassardo

83 responses so far

ma come ?!?

non era arrivata l’era glaciale ?

il riscaldamento globale non si era fermato ?

e ora come faranno gli scettici ?

… grazie, direi che i dati chiudono molte polemiche inutili

Caro Vincenzo,

coloro che si autodefiniscono scettici hanno già cominciato, ancora prima del rilascio dei dati, la litania: il 2010 è stato caldo ma non poi così tanto, i dati di NOAA gestiti dall’attivista Hansen si discostano dagli altri, peraltro di dubbia origine e verosimilmente contraffatti – isola di calore urbana, hockey stick, climate gate, ecc. ecc. ecc.

Basta vedere Climate Monitor in Italia o direttamente la casa madre di Chicago.

@Claudio Cassardo

La NOAA conferma: anno più caldo a parità con il 2005, e per l’emisfero nord il più caldo tout court – http://www.ncdc.noaa.gov/sotc/global/2010/13 –

complimenti per lo scoop.

@Vincenzo e Gianfranco

siamo nell’era glaciale, solo che la Groenlandia è un’isola di calore urbano?

Anche per la NASA il 2010 è record, a parimerito con il 2005

http://www.giss.nasa.gov/research/news/20110112/

Mi sembra che i dati parlano da soli.

Una cosa che non capisco è perchè allora si insiste cosi’ tanto che è stato un inverno freddo. E’ stato davvero cosi’ freddo? Dalle mappe mi sembra solo da alcune parti ben precise, in questo le mappe sono molto chiare

Ieri ho letto che il dott. Georgiadis scriveva tipo che l’inverno gelido ha tappato la bocca ai profeti di sventura.

Ma se il 2010 è stato cosi’ caldo allora mi sa la bocca dovrebbe essere tappata a quelli che per tanti anni ci hanno detto che il riscaldamento si era fermato.

Ma questi signori chiederanno magari scusa per averci raccontato tutte ‘ste fregnacce negli scorsi anni?

Mi sa che vado a rileggermi i post che scrivevano anni fa… sul raffreddamento globale, ma poi mi segate i link se ne metto tanti ?

@Stefano

La NASA è una copiona

@Luca

E’ uguale ogni inverno e se fa caldo in pianura, tutti a fissare il termometro appeso in cima al Monte Bianco – parete nord.

Se serve un sunto, ho qui una citazione dal post di Cli.mo. del 30 dicembre, in cui il “mainstream scientifico* attribuisce il freddo al caldo persistendo nel solito strano atteggiamento di non voler proprio guardare fuori dalla finestra, preferendo continuare a concentrarsi sui numeri che scorrono sullo schermo dei computer esattamente nell’ordine con cui vi sono stati inseriti”.

*Termine spregiativo, lo scienziato vero guarda il clima dalla finestra e inserise i numeri della temperatura a caso, nell’abaco.

Eh si’, guardate questi calunniatori incalliti non mollano:

http://www.meteogiornale.it/notizia/19563-1-metodi-nasa-global-warming-di-novembre-portato-all-eccesso

Ormai la malattia contagiosa ha invaso tutti i siti meto (?) e blog italiani, eccettuato CA che e’ vaccinato fortunatamente da queste cose.

Questa gente prima ha detto che era la NOAA a falsificare i dati, ora dicono che e’ la NASA (perche’ non gli sono piaciuti i dati novembre, quindi secondo loro sono falsi).

Gli argomenti portati sono spazzatura, e’ totalmente falso che non ci sono stazioni in Groenlandia, o nel nord del Canada (ce ne sono centinaia) o in Siberia (ce ne sono centinaia sinottiche e svariate migliaia regionali in ogni angolo).

Non e’ vero che il dato di Nuuk si e’ preso e “motliplicato” per numero X di stazioni mancanti, come calunniosamente insinua quel tale, non e’ vero che Nuuk non sta in linea con le altre stazioni groenlandesi i cui dati sono TUTTI IN LINEA PESANTEMENTE SOPRAMEDIA i cui dati sono tutti archiviati nel database NCDC/GSOD.

Sui presunti errori (che ovviamente ce ne sono) mai e poi mai questa gente (?) cita le gelate di nauru o le gelate delle foresta amazzonica nel sud del Venezuela o nelle zone costiere, chissa’ perche’ solo si parla delle stazioni che sballano verso l ‘alto e mai quelle verso il basso. Oltre che ignoranza c’e’ un disegno criminale (diciamolo, calunniare e’ un reato). Questa spazzatura si diffonde a macchia d’olio purtroppo.

E’ ora di finirla con questo schifo.

Questa gente insiste sulle loro storie dell’era glaciale e del global cooling, offendendo e calunniando tutta la comunita’ scientifica, se i dati li smentiscono dicono che sono falsi e offendono e calunniano ancora di piu’. Non se ne puo’ piu’.

Inverno freddo , eccezionale si’, nel Regno Unito, Irlanda, Benelux, parte della Francia e della Mitteleuropa.

Articoli su articoli, prime pagine, bloggers impazziti, che peccato nessuno nessuno mai mai un solo giorno un solo istante ha scritto una parola una lettera una ventata d ‘alito sulle temperature estive nelle isole Azzorre, in Islanda, in GRoenlandia, le temperature primaverili in Medio oriente, Turchia, nel Mar Nero, Penisola Arabica.

Dicembre piu freddo della storia in UK ? ooohh, l ‘era glaciale.

Dicembre piu; caldo della storia in Israele e Libano ?

Novembre piu; caldo della storia in 14 paesi ? Nessuna parola ,niente nulla, e se provi a dirlo ti dicono subito che i dati sono falsi.

Peccato perche’ i libanesi hanno spento l aria condizionata a fine novembre, a Soci in Russia sono andati a maniche corte e prendere il sole anche i certi giorni di dicembre , a Creta hanno sfiorato i 30C per fine anno per il secondo anno consecutivo (anche il 1 gennaio 2010 avevano avuto 30C). 6 mesi consecutivi record mensili di caldo nazionali in Israele e Libano ,ossia il 2003 in Europa in confronto e’ stato una sciochezzuola.

Niente. Nemmeno una parola.

Ricordo qualche mese fa in un inverno mite e parecchio sopramedia in Brasile, per soli due giorni di freddo, hanno tartassato i media, siti meteo (?) e blog con stupidaggini come neve in Amazzonia e pesci congelati (quando hanno avuto quasi 40 gradi per varie settimane di fila con 2 giorni di interruzione a 13-14C).

Ma se provavi a dire guardate che a Rio Branco ci sono 40 gradi non la neve o i fiumi ghiacciati, ricevevi insulti tipo “corrotto, lecchino del IPCC, caldofilo muori….”.

Non c’e’ niente da fare ragazzi, quella e’ FECCIA , per quei poveri ritardati mentali la scienza si riduce in caldofili freddofili e nevofili, non sanno neanche cosa sia la scienza e la professionalita’

Ah, ricordo ancora….

Secondo quella gente,ora e’ la NASA a falsificare i dati, prima era la NOAA e prima ancora erano i dati satellitari a essere falsificati , perche’ un mese furono piuttosto altini (mi sembra settembre) ,cosi’ che quella gente aveva gia’ insinuato che i dati satellitari erano truccati mentre quelli terrestri andavano bene. Ora i satellitari vanno bene e i terrestri sono truccati.

Avete capito. Hanno sempre ragione loro. Fa sempre freddo in ogni regione del mondo, qualsiasi dato che dice il contrario e’ falso.

E’ inutile spiegare dettagliatamente come si elaborano i dati e come si rappresentano graficamente, lo feci gia’ a suo tempo quando calunniarono gli altri enti, il risultato fu o non pubblicarmi i commenti o mandarmi offese e insulti.

Vorrei dire che questa gente va ignorata , ma non si puo’, purtroppo hanno una visibilita’ che consente loro di spargere a macchia d’olio queste menzogne. Sai com’e’, i bannerini, i click, arrivano i soldini, e poi hanno il coraggio di dare dei corrotti agli altri.

Penso che bisogna segnalare e denunciare queste cose, non si puo’ darla vinta ai calunniatori e disinformatori.

@ Luca Mi sa che vado a rileggermi i post che scrivevano anni fa… sul raffreddamento globale, ma poi mi segate i link se ne metto tanti ?

Certo che li togliamo

Uno dei meriti del post di Claudio è mostrare come alla fine sono i dati che danno la chiarezza del segnale del cambiamento climatico.

Chi si occupa da un po’ di tempo di questi problemi, e ricorda le difficoltà di anni or sono nell’avere dati e mappe, ogni tanto rimane ancora stupito dal dettaglio e la quantità dei dati oggi disponibili.

Poi ci sanno tante sfumature, che sono, appunto, sfumature.

C’e’ poi un’altra curiosa contraddizione dei negazionisti: ora ormai hanno fatto quasi tutti (95% dei siti e blog meteo italiani) il passo nel negare che un riscaldamento sia esistito, dicendo che i dati sono tutti falsificati. Prima negavano che la causa fosse antropica, ora ormai si nega di sana pianta che un riscaldamento globale sia esistito. Bene.

Le stesse persone ora prevedono un’era glaciale per cause naturali, in primis il minimo solare che secondo loro fara’ da apripista a una lunga serie di cicli bassissimi.

Ok, quindi avendo stabilito il loro pensiero che l’attivita’ solare e’ la principale o sola responsabile dei cambiamenti climatici e che negli ultimi decenni essa e’ stata molto forte, allora come possono ora negare che un riscaldamento sia esistito ?

Se l’attivita’ solare che in ribasso dovra’ causare un raffreddamento globale, allora perche’ l’attivita’ solare molto forte del XX secolo non ha provocato alcun GW ? Vedete che questi babbei si contraddicono da soli. Sono cosi’ patetici con la loro anti-scienza , le loro bugie e le loro calunnie che non si accorgono che si stanno smentendo da soli.

Questa malattia contagiosa e’ universale , ma in Italia e’ piu’ che mai diffusa purtroppo, non capisco sinceramente cosa sta succedendo qui, uno dopo l’altro tutti i siti meteo italiani eccetto questo sono caduti nella melma delle teorie negazioniste/cospirazioniste che gridano all’era glaciale. Sara’ solo una caccia ai click sui banners che ormai tapezzano questi siti ? Mi era in tal senso giunta una voce quando un paio di settimane fa su un sito meteo ebbero il coraggio di scrivere che aveva nevicato in Australia fin sulle coste (la cui temperatura era stata compresa nelle 24 ore precedenti fra 13 e 29 gradi), poi mi e’ stato detto che tutto cio’ sono invenzioni volute per accrescere i click.

Quindi bugiardi in mala fede che mentono solo per accrescere le visite ai loro siti (che qualita’ di visite, poi ) hanno poi il coraggio di dare dei corrotti alla comunita’ scientifica.

Nell’articolo che ho citato si calunniano oltre la NASA, indirittamente il servizio meteo danese e quello norvegese (insinuando che i dati delle Svalbard sono truccati, grandissima bugia).

Non e’ un segreto che in estate o quando mancano ondate di freddo questi siti vedono un grande calo nelle visite. Quindi in poche parole ora hanno trovato lo stratagemma di dire che fa sempre freddo, che la comunita’scientifca trucca i dati, e che siccome fa sempre freddo, visitateci e cliccate nei nostri bannerini che vogliamo far soldi in fretta.

Penso sia dovere di chi e’ integro e onesto oltreche’ competente in materia, mettere in guardia da queste persone che inquinano e avvelenano l’informazione a solo scopo di lucro.

[…] tutto il 2010 è stato reso disponibile proprio in questi giorni, con i clamori che si convengono ad un’annata caldissima; ma ci sono cose interessanti da vedere anche nelle medie del decennio […]

[…] così, i profeti di sventura sono ammutoliti. E se le vengono di nuovo quelle domande spontanee, faccia un bel respiro profondo e ripeta ad alta […]

In questa interessante research news della NASA:

http://www.giss.nasa.gov/research/news/20110113/

James Hansen discute sull’accordo tra le diverse serie di temperatura media globale da misurazioni strumentali e spiega come siano in buon accordo tra loro, eccetto per alcuni dettagli, tipo che l’anno più caldo in una serie finora era il 1998 (CRU/MetOffice) e che nelle altre due era il 2005 (NASA e NOAA), dettagli che possono generare confusione tra la gente comune e possono portare a pensare che i risultati dei diversi team sono sensibilmente differenti tra loro o che le incertezze coinvolte sono molto grandi. Come riporta il post, in realtà il tutto dipende solamente da come i dati grezzi vengono analizzati per determinare il valore medio globale (vedi la mappa del mondo nella pagina web).

12esimo anno di stasi termica globale. GW fermo al palo da oltre un decennio.

a risentirci nel 2012! 🙂

eh eh

giulio non so chi tu sia ma non sai nemmeno leggere i dati; tu sei giulio Dunning o giulio Kruger?

come fai a pensare di poter usare solo il piccolo set di dati che ti dicono quel che vuoi? per parlare di clima devi usare almeno gli ultimi 30 valori, ALMENO;

ripeto sei Dunning O Kruger?

o entrambi?

il gemello di GG

Bello non ricorrere al metodo scientifico vecchio di qualche secolo, si puo’ dire cio’ che si vuole, anche che la terra e’ piatta e il sole gira intorno alla terra.

[…] un pochetto con la realta’, quella che cerchi sempre di schivare. —————- Da Climalteranti.it

[…] evidenziato la differenza tra meteorologia e climatologia – vedasi ad esempio qui o qui e la recente analisi climatica globale del 2010 – ma dato che ogni qualvolta che in Italia si verifichi qualche nevicata significativa preceduta o […]

Complimenti per la descrizione semplice e accurata nello stesso tempo e con la semplicità con cui esponete argomenti complessi. Ben fatto.

[…] nei giorni scorsi, riprendendo l’Organizzazione meteorologica mondiale (Wmo), ne ha fatto un post molto dettagliato il sito Climalteranti, punto di riferimento per chi è interessato ad […]

Sono un po’ preoccupato nel leggere il 2010 come anno più freddo del normale, rispetto alle medie 61-90. A me è sembrato caldo! Eppure anche i miei dati di Cafasse confermano che il 2010 è mediamente l’anno più “freddo” dal 2002 in avanti (11.7°C di media, il più caldo è stato il 2007 con 13.1°C). Forse hanno contribuito le nebbie di gennaio e le piogge d’agosto.

Per il resto sulle mie vicine Alpi Occidentali continuano a registrarsi inverni assai miti, con neve tendente a sciogliersi fin oltre i 2000m.

Anche oggi 30 gennaio nevica sì a Torino, ma a Balme (1432m, Alpi Graie Meridionali) la temperatura è salita fino a +1°C)

Ma allora gli anni ’80 quando nevicava tanto e faceva un gran freddo com’erano rispetto alle medie ’61-90?

Vedere questo sito per maggiori dettagli sulla meteorologia di Cafasse.

@Giulio

“…12esimo anno di stasi termica globale. GW fermo al palo da oltre un decennio….”

Questa la trovo la frase “climaticamente” + importante e corretta di questa pagina.

Chi fosse realmente interessato alla climatogia e non al “giornalismo” pseudo-climatico si dovrebbe chiedere come mai non c’e’ + crescita delle temperature medie globali, oceani, troposfera, suolo.

Invece per “giornalismo” pseudo-climatico si omettono anche le cause che hanno portato il 2010 ad essere tra i piu’ caldi della serie (o fascia climatica) degli ultimi 12 anni: il forte Nino.

Si omette di dire che il 2011 sara’ ovviamente molto più fresco del 2010 a causa di un evento opposto: la Nina.

Inoltre, per “giornalismo” pseudo-climatico si dicono cose come questa:

“Il fatto che le temperature superficiali mostrino anomalie positive e quelle stratosferiche invece anomalie negative è una delle conseguenze attese dell’incremento dell’effetto serra (si veda ad esempio qui).”

Omettendo il fatto che la stratosfera leta dai satelliti e’ in stasi climatica, non dal 98, ma bensi’ dal 1994 !!! Nessuna diminuzione da allora, dopo il calo dovuto al Pinatubo.

Queste dovrebbero essere delle vere domande climatiche, quelle che ci riguardano piu’ da vicino, che riguardano i nostri anni …. di stasi climatica.

Curiosa l’affermazione di 12 anni di trend nullo, soprattutto perchè vorrebbe dire partire dalla nina del 1999 mentre in genere agli scettici piace calcolare i trend dalla sommità di un bel nino come quello del 1998 ( e quindi sugli ultimi 13 anni); ma anche così il giochetto non funziona più tanto bene specie nel gistemp e nella ricostruzione preferita dagli scettici quella satellitare dell’università dell’alabama dove il trend 1998-2010 è chiaramente positivo:

http://img826.imageshack.us/img826/7559/trenduah.png

Trend che ovviamente non è statisticamente significativo ma per questo in media ci vogliono circa 18 anni per i dati satellitari percui se ne riparla tra ~5anni, nel frattempo il riscaldamento continuerà a fermarsi innumerevoli volte con tanti altri bei ed insignificanti microtrend negativi….

@Alessandro

Le T degli ultimi 12 anni sono tutt’altro che statiche. Il rateo è inferiore agli anni 90, ma se analizziamo come cambia il trend nel tempo (applicando una semplice funzione polinomiale di secondo grado), vediamo come in realtà il GW stia addirittura accelerando. Ma ovviamente si parla di trend e quindi da scorgere sul lungo periodo, onde smussare la variabilità interannuale.

Anche l’OHC continua ad accumularsi, se si tien conto delle opportune correzioni indotte da cambio di strumentazione (dai sistemi XBTs alla flotta ARGO) e da vari bias scoperti, vediamo come l’oceano continui ad accumulare calore (anche se, di nuovo, con un rateo inferiore a quello degli anni 90 e dei primi anni 2000), vedi ad es.:

http://www.nature.com/nature/journal/v465/n7296/abs/nature09043.html

T stratosferiche: io ci avevo fatto un post.

Anche in quel caso, non è completamente esatto che le T siano statiche dal 1994, non in tutta la colonna stratosferica e non sopra di essa. E in ogni caso ci sono ragioni fisiche che spiegano l’andamento step-like, non solamente riconducibili all’ozone depletion indotta dagli effetti chimico-radiativi della presenza di gas clorati di origine antropica (come i CFC) dopo grandi eruzioni vulcaniche come il Pinatubo.

Sulla questione delle temperature stratosferiche il link presente nell’articolo contiene già la risposta, dal 1993 la concentrazione di ozono è tornata leggermente ad aumentare , quanto basta per annullare il trend negativo dovuto alla sola co2 almeno nella bassa stratosfera.

http://www2.sunysuffolk.edu/mandias/global_warming/greenhouse_gases.html

Patrignani ma che senso ha parlare di clima su 16 anni o addirittura su meno? il clima va stimato su tempi di almeno 30 anni o più; ma la distinzione fra clima e meteo la conosci? siamo ancora a queste distinzioni di base? ma per favore prima di scrivere boiate leggetevi le carte

@ claudio della volpe

Guarda Claudio, concordo in pieno con il tuo intervento fino a quando dici “Il clima va stimato su tempi di almeno 30 anni o più”.

La seconda parte del tuo intervento mi sembra invece piu’ in linea con altri blogs dove e’ la rissa fine a se stessa a prevalere. A me piacerebbe che almeno su Climalteranti la sezione dedicata ai commenti, fosse un posto dove, soprattutto chi sbaglia, viene sempre e comunque rispettatato.

Uno puo’ sbagliare per tanti motivi ed un errore puo’ essere molte volte perfino un’occasione per imparare qualche cosa di nuovo. Magari mi dirai: ma quando c’e’ la malafede questo non vale….

Penso che uno degli errori in cui si incorre piu’ frequentemente (senza rischiare in questo caso di imparare nulla) e’ quello di vedere il negazionista sempre e comunque in malafede. Per carita’ puo’ anche essere in certi casi. Tuttavia per un scientist che basa le sue valutazioni su evidenze concrete, il giudicare la buona o la malafede degli altri mi sembra qualcosa che, fino a prova contraria, va molto al di la delle sue competenze.

Paolo hai ragione, ma quando leggo certe cose mi pare di rivedere quella gag in cui ci sono due carabinieri e uno chiede all’altro funziona la freccia e quello risponde: adesso si adesso no.

@Claudio della Volpe

probabilmente sei te che scrivi “boiate” su COSA sia il CLIMA e i vari modi in cui questo possa essere letto. E come questo possa variare anche in modo improvviso non lo leggerai MAI con i trend trentennali. Se non capisci che cosa vuol dire quando il clima oscilla in una “fascia climatica” definita e orizzontale e quando questo sia pendente verso l’alto o il basso non riuscirai mai a leggere il clima (confrontandolo con i meccanismi climatici attivi in quel momento (per esempio ENSO media diminuita, PDO media diminuita ecc…).

30 anni e’ UNA CONVENZIONE, per riuscire a leggere andamenti di lungo termine e quindi i comportamenti medi e su questo siamo d’accordo. MA il clima puo’ variare improvvisamente, come ha fatto intorno al 44 e come ha fatto intorno al 1976 e leggere i “trend” trentennali prima di questi episodi non poteva in alcun modo far capire cosa stava succedendo. Invece osservando il breve-medio periodo si puo’ leggere qualcosa di + indicativo sul clima ATTUALE e i potenziali per il futuro.

A Steph posso dire che di studi ce ne sono tanti e discordi, io mi riferisco ai dati ufficiali di Willis, pubblicati dal NODC-NOAA.

A GP faccio osservare che proprio il grafico che mi posta:

http://img826.imageshack.us/img826/7559/trenduah.png

accerta quello che avevo detto, cioe’ fascia climatica di oscillazione ORIZZONTALE, minimi e massimi che non vanno ne su e ne giu, stasi climatica. Il “trend” scendera’ in negativo con i riflessi Nina, poi tornera’ in lieve positivo su eventuale altro Nino, ma SE non si alzano i minimi e i massimi si rimane in STASI climatica.

@ Alessandro Patrignani

“30 anni e’ UNA CONVENZIONE, per riuscire a leggere andamenti di lungo termine e quindi i comportamenti medi e su questo siamo d’accordo. MA il clima puo’ variare improvvisamente..”

Guardi, non si tratta di convenzioni ma di trends statisticamente significativi o meno. Meno il trend e’ accentuato e piu’ anni sono necessari per stabilire che il trend e’ significativo al tot %. Se invece il trend e’ estremamente accentuato, allora bastano anche pochi anni. Nel passato puo’ vedere ad esempio: High-Resolution Greenland Ice Core Data Show Abrupt Climate Change Happens in Few Years (http://www.sciencemag.org/content/321/5889/680.abstract). Oggi la situazione e’ pero’ completamente diversa e l’aumento di temperatura e’ statisticamente significativo sull’ordine dei 30 anni. Inutile quindi dire che non c’e’ stato nessun aumento di T negli ultimi 10 anni perche questo corrisponde praticamente a dire che non c’e stato nessun “abrupt climate change”. Ed allora si sfonda una porta aperta perche’ nessuno ha mai fatto un claim del genere. Questo non vuol dire che in futuro un “abrupt climate change” non possa capitare, superando ad esempio un tipping point. Ma su questo la ricerca e’ in pieno svolgimento ed e’ piu’ che legittimo essere scettici a riguardo.

@Paolo Gabrielli

Paolo non nascondiamoci dietro “tecnicismi” poco significativi (quali “trend statisticamente significativo”) perche’ queste cose con il clima su scala medio-breve NON hanno alcun significato.

Guardiamo bene i dati REALI (o almeno quelli misurati con i loro errori inevitabili) e andiamo a scoprire COSA e’ successo negli ultimi anni, dal punto di vista climatico, effettivo, reale.

http://www.drroyspencer.com/wp-content/uploads/UAH_LT_1979_thru_Jan_2011.gif

Allora cosa e’ successo negli ultimi 30 anni ? E’ successo che dal 79 al 1997 siamo stati su uno status climatico piuttosto stabile, ondulato dagli eventi Nino/a e vulcanici che portano i due minimi del 83-7 e 92-3, status climatico che possiamo individuare nella fascia tre -0,1 e +0,1° nel grafico UAH. Il 98 e’ un evento estremo, probabilmente portato a questi eccessi (solo nel 1878 un evento simile) dalla precedente esplosione isolata del Pinatubo, e che ha indotto una serie di riflessi oceanici immediati (abrupt climate change) agevolati dalla fase di salita delle anomalie in zona nord atlantica.

Lo status climatico ha avuto uno “step” immediato dovuto anche dal forte afflusso di acqua in atmosfera e da allora oscilla su una fascia media che nel grafico si puo’ riscontrare tra +0,1 e +0,4°.

Poi se volete nascondervi dietro trend, trendini e “statistiche significative” fate pure ma i dati parlano chiari e ci dicono pure che nonostante l’aumento notevole nello status oceanico medio (soprattutto AMO e IPWP) che avrebbe dovuto “teoricamente” portare ad un aumento anche forte nello status climatico, questo in realta’ e’ rimasto fermo perche’ sono venute a mancare le condizioni di spinta media in zona ENSO.

@Alessandro

A parte il fatto che non è come dici, la tua analisi è molto incompleta (ad es. solo improntata su un dataset troposferico).

Ma soprattutto: buttare nel WC la statistica mi va anche bene, ma allora coerenza in tutto, p.f. L’hockey stick di Mann insegna…

OHC: dati ufficiali sono anche quelli presenti nello studio che ho linkato, ci sono anche quelli afferenti al lavoro di Willis (visto che ne è pure coautore) e lo studio è uno dei più recenti a riguardo.

Vabbè se avere trend significativi non conta non so proprio che senso possa avere mettersi a discutere dell’andamento delle temperature globali….tanto più che l’interesse principale è verificare se le proiezioni sono consistenti con le simulazioni modellistiche e su questo c’è un post recente su RC con le comparazioni comprese temperature e OHC che è piuttosto chiaro.

Willis è coautore del lavoro di Lyman che appunto ha riunito i vari gruppi che si occupano di ricostruzioni dell’ohc e il cui pregio è aver mostrato come la variabilità interannuale è dipendente dalle scelte fatte per rendere la serie omogenea e solo il trend di lungo termine ha significato climatico…

Patrignani guarda che 30 era solo un numero minimo indicativo; minimo; ho scritto 30 anni o più;hai letto?

ora in questo periodo che pure è il MINIMO concepibile, ti sfugge un piccolo dettaglio la t media è aumentata di 0.4°C circa;

il resto è noia; e sinceramente il mio scopo non è convincerti o coinvincere gli scettici come te; me ne frego; per voi serviranno fatti grossi; e ancora qualche decennio; ma sai il tempo è galantuomo.

buonanotte

@ Alessandro Patrignani

La significativita’ statistica di un trend non e’ per nulla un tecnicismo ma l’ABC della climatologia. Come sapra’, la climatologia non e’ altro che la statistica della meteorologia e quindi se si prescinde dalle analisi statistiche si fanno solo descrizioni meteorologiche che pero’ lasciano proprio…il tempo che trovano. Vedo che e’ appassionato degli scambi di calore tra oceano e atmosfera: ottimo, spiegano una parte importante della variabilita’ inter-annuale. Tuttavia fenomeni come l’ENSO non sono delle forzanti in grado di modificare la climatologia del pianeta intero sul lungo periodo. Sicuramente pero’ l’ENSO influenza gli andamenti meteorologici stagionali, che poi e’ quello che continua a dirci lei, dicendoci pero’ che si tratta di andamenti climatici.

@Claudio della Volpe

Claudio provi a porsi temporalmente nel 1940 oppure nel 1973 con i trend 30ennali o oltre. Sa cosa ci fa ? Niente, non le danno alcuna informazione sul clima di quel momento e quello che avrebbe potuto succedere nel futuro.

Io ho posto l’accento sull’analisi di BREVE-MEDIO termine e mi sembra che lei non abbia colto il significato climatico di cio’.

Per capirci, lei dice: 30 anni +0,4°. OK, ma anche 20 anni +0,4° e gli altri 10 anni +0° …. climaticamente c’e’ una bella differenza, il resto e’ davvero noia.

Inoltre scettico lo vada a dire a qualcun altro, io studio i DATI CLIMATICI e non mi pongo quesiti “teoretici” che spettano alla scienza e che non ha certezze di alcun tipo. Quindi guardo i dati e cerco di leggerne i significati climatici fenomenologici, quelli teoretici non si leggono e non c’e’ modo di leggerli allo stato attuale delle conoscenze.

@Paolo Gabbrielli

Nulla da eccepire sul discorso delle analisi statistiche, ma anche a lei ripropongo il significato della differenziazione tra lungo termine e breve-medio. Concordo che il breve termine non puo’ fornire un dato statistico “forte” ma puo’ consentire di capire meglio lo status climatico.

Sulla ENSO siamo lontanissimi. Pensi solamente che la differenza tra 44-76 e 77-200x nel valore MEDIO della zona ENSO e’ di +0,4° !!! Ha capito bene, 0,4° per 30 anni ! Se ha capito come funziona il coupling oceano-atmosfera spero che non dira’ + che la ENSO non possa essere una forzante climatica. Lo e’, lo e’ nel breve, ovviamente, ma lo e’ anche nel lungo termine e strettamente legata al ciclo generale del Pacifico (ma in realta’ mondiale) e una misura di questo puo’ essere letta nella PDO.

@Alessandro

statistica: ma allora, e di nuovo: provi a fare un fitting, per es. attraverso una polinomiale di secondo grado. Così facendo lei potrà scorgere come sta cambiando nel tempo il trend. Vedrà cose molto interessanti.

ENSO: non è in alcun modo una forzante, non lo può essere perché ciò che forza sono fattori che squilibrano il bilancio energetico globale e qualsiasi oscillazione interna non lo può fare. L’ENSO è una dinamica interna di corto periodo del sistema oceano-atmosfera, la più importante. Che possa subire l’influenza dello squilibrio radiativo fra energia entrante e uscente del sistema può anche essere. Che ciò influenzi l’accumulo (Nina) e lo scarico (Nino) di energia può essere. Che questo sbilanciamento possa in qualche modo influire sulla variabilità termo- e idrodinamica interannuale modulata dall’ENSO ok. Ma questo non vuol ancora dire che l’ENSO possa essere considerato una forzante del sistema.

In quanto variabile interna, non va ad agire sui forcing radiativi, ma semmai li “maschera” trasferendo l’energia accumulata dal sistema all’interno del sistema stesso: ad es. redistibuisce le sorgenti di evaporazione e gli associati flussi di calore latente, amplificando nel caso del Nino (o riducendo nel caso della Nina) l’evaporazione dalle zone oceaniche tropicali, raffreddandone (o riscaldandone) in seguito le acque e, parallelamente, favorendo (sfavorendo) la convezione sulle aree oceaniche più calde (più fredde). In sostanza l’ENSO “sposta” le aree di immissione di vapore e, per la legge di C-C, ovviamente anche quelle nelle quali il vapore ricondensa. Il calore viene così trasmesso dagli oceani all’atmosfera (attraverso l’evaporazione), rilasciato sottoforma di calore latente (attraverso la condensazione) e redistribuito teleconnettivamente attraverso le avvezioni in atmosfera (a 35° di latitudine l’atmosfera è responsabile di quasi l’80% del trasporto meridionale di calore nel NH e di più del 90% nel SH).

ma che senso ha porsi temporalmente nell’anno che dice lei, uno specifico anno scelto a caso o apposta? e poi fare analisi invece che a tempi crescenti sopra 30 a tempi decrescenti!!! è tutto da ridere, fare analisi climatiche a breve medio termine usando 20 o addirittura 10 anni; meno di 30 non esiste come intervallo; è OVVIO che scegliendo all’interno di un set di dati che è almeno di 160 anni ci saranno gruppi di dati anche di trenta dati che danno trend in su o in giu’, ma NOI LI ABBIAMO TUTTI!! e quindi possiamo guardare alla loro globalità; fare analisi climatiche a breve medio termine nel senso che dice lei è quasi un ossimoro puro; dobbiamo parlare di secoli non di decenni;

se studia dati climatici e lo fa veramente allora lei ha almeno 160 anni di dati omogenei che le dicono con enorme chiarezza che la terra si sta scaldando; punto;

il clima è ciò che resta astraendo dalle oscillazioni a breve e medio termine per parafrasare ciò che dice;

fra l’altro negli anni della II guerra è assodato che ci siano degli errori di raccolta dati ancora non corretti che furono indicati recentemente anche da Zecca e altri su le Scienze e che quella sorta di picco locale non esiste (e infatti non è compreso in alcun modello)

ripeto creda quel che vuole ; gli “scettici-data based” forti della loro misconoscenza della statistica come lei devono cuocere nel loro brodo; il problema climatico è UNO degli elementi che indicano il nostro influsso sulla biosfera; non vede attorno a lei la crisi energetica, e i problemi delle risorse che stanno catalizzando movimenti sociali enormi? il pozzo atmosferico o la sorgente petrolio o fosforo o quel che vuole sono tutti esempi contemporanei delle crisi che furono già indicate dal gruppo di limits to growth; il tempo stringe e non si puo’ rimanere indietro a convinecre gli scettici blu.

adieu

@ Alessandro Patrignani

Sull’ENSO le ha gia’ risposto ottimamente Steph (grazie) ma vorrei aggiungere un bell’ esempio, mi sembra di David Archer, per capire bene come si distingue una forzante del sistema (e.g. variazione dell’intensita’ solare, dei gas serra, dei solfati) da una semplice oscillazione (l’ENSO, le bipolar seesaw).

Se il nostro sistema terra e’ una vasca ed il bilancio energetico e’ il livello dell’acqua, allora le forzanti sono quelle che ne fanno aumentare o diminuire il livello (gas serra e solfati) mentre un’onda che va avanti ed indietro lungo la vasca (l’ENSO) modifica il livello dell’acqua localmente ma in media il livello della vasca rimane tale e quale. Ecco perche’ l’ENSO non puo’ essere considerato una forzante vera e propria.

@Steph

“ENSO: non è in alcun modo una forzante, non lo può essere perché ciò che forza sono fattori che squilibrano il bilancio energetico globale e qualsiasi oscillazione interna non lo può fare…”

Siamo molto lontani su questo Stefano.

Gli Oceani non sono una massa alla stessa temperatura che varia in dipendenza delle “forzanti esterne”. Hanno temperature diverse x profondita’ e latitudine e mosse da correnti in giro per il mondo in modo VARIABILE nel tempo.

L’incidenza delle forzanti esterne c’e’ ovviamente, in superficie e poi mixata nella massa dalle correnti ma rimane una massa con distribuzione termica assai diversificata.

Il clima e’ influenzato enormemente dall’andamento superficiale oceanico, dal layer di interfaccia ….. ma questo varia nel tempo e sono queste variazioni che fanno la storia del clima e quindi se fai 2 + 2 troverai che l’ENSO MEDIA E LE DISPOSIZIONI SUPERFICIALI OCEANICHE SONO FORZANTE climatica, la + potente che esista (a parte gli eventi estremi di altra origine).

Prova a spiegarmi il climate change del 1976, con la realizzazione di oltre il 50% del GW troposferico in solo 4 anni, con le forzanti esterne ! Semplicemente non puoi, come non puoi spiegare quello del 1944, l’Oceano puo’, il sistema stesso puo’ !

http://globalwarming.blog.meteogiornale.it/files/76-ratpac300-1203.JPG

http://globalwarming.blog.meteogiornale.it/2009/12/07/climate-change-il-1976

@Paolo Gabrielli

Paolo, io le propongo quest’altro esempio:

ha una vasca dove ha dell’acqua, fredda nella parte profonda e calda nella parte superficiale. Ha un termometro che misura la temperatura della superficie.

Comincia a soffiare un vento teso da una parte all’altra della grande vasca e pian piano dal lato da cui arriva il vento notera’ che le temperature della superficie tenderanno a calare, sempre di piu’, infatti stara’ emergendo acqua + fredda dal fondo.

Ora applichi questo schema grossolano alle varie situazioni GLAAM terrestri e notera’ che quando questatende a diventare negativa avra’ diminuzione delle temperature superficiali oceaniche e il contrario con GLAAM positiva. Ora se il sistema proponesse solo oscillazioni + e – uniformemente distribuite del tempo avra’ solo una oscillazione delle temperature medie superficiali a somma 0.

MA se avra’ uno sbilanciamento GLAAM medio per lungo tempo vedra’ che le superfici oceaniche tenderaano a diminuire o aumentare (in dipendenza del segno).

E e’ quello che e’ successo dal 1976 al 1998 con GLAAM medio ben positivo, poi il GLAAM medio e’ tornato verso il negativo con l’eccezione di una fase positiva tra 2002 e 2004, e, guarda caso, il “trend” della salita delle temperature che si era visto tra 1976 e 1998 si e’ interrotto di brutto rimanendo piatto.

Lei, e Stefano, potrete dire quanto volete che le forzanti interne al sistema si equilibrano, ma in realta’ questo NON e’ vero nel medio periodo climatico (quello adatto per guardare gli episodi degli ultimi decenni).

Posso seguire il vostro ragionamento SOLO ed esclusivamente sul lungo periodo.

Non so se questo link sia già stato postato, ma credo sia molto in tema con il dibattito sviluppatosi in questo post e, tra l’altro, le conclusioni sono interessanti.

“influence of choice of time period on global surface temperature trend estimates”, sul numero del BAMS dello scorso novembre

http://journals.ametsoc.org/doi/pdf/10.1175/2010BAMS3030.1

bella la vasca con una forzante interna che però è in origine asimmetrica; per capirci non venti che vanno in tutte le direzioni ma un vento che va in una direzione sola; a cosa corrisponderebbe nel caso reale?

le forzanti interne devono rispettare i principi della fisica e della chimica, ossia i principi di conservazione e le simmetrie del sistema; se uno si fa una forzante pseudointerna ad hoc…..

« Il riscaldamento globale non si è mai fermato; ma se si fosse fermato, nel 2010 è ripartito”

Ma questa battuta di chi è? Coyaud o Caserini?

Urge urgentemente una rettifica

http://www.climatemonitor.it/?p=15733

@ redazione

a proposito nel post sull’anno nero per i negazionisti, (da cui è tratta la citazione in prima riga) vorrei sapere perchè Steph Reitano e Della volpe possono fare dozzine di post ed io invece vengo censurato al 6° senza nessuna possibilità di replica nemmeno verso chi mi insulta, (la Coyuad mi definisce mostro : lei che in quanto a mostro..)

e vorrei pure sapere perchè avete censurato il link alla descrizione del catastrofismo galoppante di Hansen

Costa

direi che urge una rettifica da parte di Guidi visto che nel grafico mostra evidentemente il mese più caldo, non l’anno. Parlare in termini annuali e mostrare dati mensili è senz’altro fuorviante.

A parte le solite insinuazioni sui dati di superficie “migliore amico dell’uomo”, non dubito che Guidi sappia che i dati troposferici tendono a mostrare una particolare sensibilità all’ENSO. In ogni caso, il dato annuale 2010 UAH mostra un sostanziale pareggio con il 1998.

Mi sorprende la sua mancanza di spirito critico nei confronti di un’analisi così mal fatta.

@ Costa

è ovvio che gli autori del blog, i membri del CS e i suoi collaboratori non hanno limiti al numero dei commenti

il commento a cui fa riferimento violava le norme della netiquette; era già successo e la prima volta siamo stati undulgenti, come facciamo spesso anche con Lei.

@ Reitano

la rettifica era nei confronti della frase citata sul riscaldamento che viene appena dopo quest’affermazione sempre di Caserini -Coyaud

“il 2010 è stato uno degli anni più caldi da quando esistono le serie storiche delle misure globali (il più caldo per WMO, NOAA e NASA-GISS, il secondo per il MetOffice)”

Non mi risulta sia così nelle media annuali citate da Guidi.

Comunque ho girato le sue critiche sul grafico delle satellitari e le hanno risposto.

http://www.climatemonitor.it/?p=15733&cpage=1#comment-11637

@ Caserini

Che il post vietata l’etiquette già lo sapevo, lo aveva scritto, ma è il motivo che manca.

L’imortante è capirsi se no, ricapita.

Su n di post sapevo che gli autori potessero rispondere a piacimento non che tutto il comitato potesse farlo, la trovo una cosa ulteriormente iniqua, in pratica gli scettici hanno 5 post per discutere gli altri infiniti. Tra l’altro quelle sui blog tematici come questo sono solo discussioni, confronti, che non cambiano nulla sullo stato delle cose, e sulle scelte politiche quindi davvero non mi spiego la necessità di limitare i post.

Costa

mi sembra appropiato dire che “è stato uno degli anni più caldi”. Nota bene, non il più, uno dei più; saltando da un blog ad un altro a volte si fanno dire cose che magari si è letto altrove. Per il resto, guardi e analizzi lei stesso i dati disponibili su internet, così si può rendere conto della differenza fra mese ed anno più caldo e di quanto è la differenza con gli altri anni rispetto alla variabilità. Dal grafico UAH mensile questo non si può vedere.

Detto questo, non sono affatto un appassionato delle classifiche dei singoli anni. La varibilità interannuale è di gran lunga superiore al trend, che invece è ciò che conta quando si parla di global warming.

@Claudio della Volpe

“bella la vasca con una forzante interna che però è in origine asimmetrica; per capirci non venti che vanno in tutte le direzioni ma un vento che va in una direzione sola; a cosa corrisponderebbe nel caso reale?

le forzanti interne devono rispettare i principi della fisica e della chimica, ossia i principi di conservazione e le simmetrie del sistema; se uno si fa una forzante pseudointerna ad hoc…..”

Claudio io le ho parlato di venti superficiali, di GLAAM e di oceani che notoriamente non e’ una massa d’acqua a temperatura uguale in tutte le sue parti. Non credo che a un esperto di clima serva altro per capire. Ma mi spiego meglio:

Le ho spiegato che cosa e’ “il vento che passa sulla vasca”, e il fatto che questo vento (equatoriale per la precisione, equatoriale e che quindi e’ connesso a tutto il resto della circolazione mondiale a partire dagli alisei) rende prevalenti gli upwelling di acqua + fresca profonda oppure rende prevalenti le stasi e riscaldamenti delle acque superficiali.

Questo meccanismo ha un ciclo di circa 60 anni e ha un impatto sul clima ENORME !!

@ REITANO

le cito la parte che volevo sottolineare( ma non a lei in particolare)

“Per il GISS della NASA, dataset curato, coccolato, massaggiato, ma non ancora corretto ( perchè manca il mese di Dicembre che è stato freddo) da James Hansen, il 2010 è stato l’anno più caldo.

Per la NOAA alla fine si è trattato di un pareggio con il 2005.

Per il Met Office e per la Japan Meteorological Agency è stato secondo.

Per l’Hadley Centre (sempre inglese) è stato terzo.

Qualcuno lo farà notare? Non credo proprio.”

@ Reitano

Aggiungo che se si aprla di trend 30ennale come si dovrebbe siamo in riscaldamento, tanto per chiarire, ma non è nulla di straordinario, è da inquadrare nei ratei in tutti gli altri picchi di riscaldamento dell’holocene e dell’eemiano.

Non trovo corretto invece che ad ogni estate calda si urli all’AGW mentre se c’è un inverno freddo la si giustifchi con un’oscillazione naturale con la nina e la PDO-, quando invece sia il 1998 sia il 2010 sono coincisi con el nino.

Caro Costa, per cortesia, secondo, terzo, cos’è il giro d’Italia ? Per favore, si rilegga le ultime 2 righe dell’ultimo commento di Riccardo Reitano e ci mediti sopra…c’è la chiave di tutto il global warming. Cari saluti

@ Cacciamani

le ultime due righe di reitano sono queste

“Detto questo, non sono affatto un appassionato delle classifiche dei singoli anni. La varibilità interannuale è di gran lunga superiore al trend, che invece è ciò che conta quando si parla di global warming.”

su questo non c’è nulla da discutere, sono perfettamente d’accordo come specificato.

& Costa

Bene, allora conviene con me che il trend di riscaldamento globale è una realtà, non mi sembrava di averglielo mai sentito dire…visto che il trend di lungo periodo (diciamo dal 1900 ad oggi) è positivo (e ancora più marcato quello degli ultimi 50 anni, e ancora di più quello degli ultimi 30 e questo anche su aree limitate, ad esempio il nord Italia, mi creda sulla fiducia,…).

Ovviamente, certo che esiste la variabilità che si soprappone al trend (ha presente la funzione: F(t)=t * sin(t), t è il tempo in anni… E’ qualcosa del genere, per brutalizzare…). Questo spiega perchè un inverno freddo non significa quasi nulla cosi’ come un’estate calda, perchè quella è, appunto, variabilità (appunto: la parte del seno di t: sin(t))…pero’ non si scordi che c’è anche la moltiplicazione per t che fa crescere la funzione nel tempo (si faccia il grafico…) assieme alle sue oscillazioni. E questa crescita avviene su scale temporali superiori a quelle year-to-year variability…

Se conviene siamo a posto. Se non conviene, la possiamo anche smettere. Il dibattito diverrebbe sterile e noioso per chi legge

@Costa per interposta centralina (o il contrario)

“Per il GISS della NASA, dataset curato, coccolato, massaggiato, ma non ancora corretto ( perchè manca il mese di Dicembre che è stato freddo) da James Hansen, il 2010 è stato l’anno più caldo.”

Curato, coccolato e massaggiato sono parole senza senso, in questo ambito. O forse vuoi farci credere che i dataset satellitari non subiscano cure, coccole e massaggi? E magari invece – secondo te – ne avrebbero bisogno quelli sul magnetismo solare nel XX secolo, visto che non fittano bene con l’andamento delle T globali? Dai, non siamo nati stamane.

https://www.climalteranti.it/2011/01/27/il-2010-un-altro-anno-nero-per-il-negazionismo-climatico/#comment-65564

Intanto: scommettiamo che, mentre un anno fa le stazioni sottostimavano (infatti nessuno parlava di cure, coccole e massaggi, o erano cure, coccole e massaggi autolesionisti?) e i satelliti avevano la febbre (perbacco! e come li hanno curati?), già ora ma anche nei prossimi mesi le stazioni continueranno a sovrastimare e i satelliti, nel frattempo guariti, continueranno ad essere in piena forma?

Chissà come mai? (domanda retorica).

Patrignani rimane un fatto: l’esempio di cui lei parla non rappresenterebbe adeguatamente una forzante, ma come lei STESSO dice un meccanismo di oscillazione di medio periodo; esempio improprio direi

@Claudio della Volpe

No, non direi che è “improprio” perche’ queste oscillazioni prendono un periodo di circa 60 anni, 30 di fase calante e 30 ascendente e l’ultima fase ascendente è cominciata in modo forte e immediato nel 1976 ( http://globalwarming.blog.meteogiornale.it/2009/12/07/climate-change-il-1976/ ).

Quindi ha impattato in modo molto forte proprio gli anni che arrivano fino a noi (30 anni sono fino al 2006). Quindi, di fatto, e’ una forzante di medio periodo, ma non sappiamo se i cicli oceanici sottendano cicli superiori, fasi cicliche più lunghe dei 60 anni, magari legate agli andamenti ciclici magnetici solari.

Concordo con Cacciamani su:

“Ovviamente, certo che esiste la variabilità che si soprappone al trend (ha presente la funzione: F(t)=t * sin(t), t è il tempo in anni…”

Ma non mi sembra ci sia molta chiarezza sul “trend di fondo” che possiamo osservare dai dati tra inizio secolo e quelli attuali. Per esempio, quell’ultimo minimo PEG tra 1880 e 1910 circa fu oltre che forte minimo solare anche forte picco distribuito di aerosol stratosferici e quindi credo sia difficile fare i conti sul “trend di fondo” solo con le considerazioni legate ai GHG.

Per esempio le fasi più “vuote” di aerosol stratosferici risultano proprio le due fasi di aumento tra 1920 e 40 e tra 76 e 200x (a parte i due isolati eventi di El Chichon (che porto’ il periodo freddo 83-87) e Pinatubo.

Insomma spero di essere stato chiaro, la focalizzazione sui GHG di natura antropica può essere fuorviante per la ricerca sui meccanismi climatici che vedono al centro l’elemento più vitale e sacro che esista, l’ACQUA … veda anche che cosa possono comportare le fasi oceaniche positive sull’H2O atmosferica: http://globalwarming.blog.meteogiornale.it/2011/01/25/umidita-specifica-dati-di-superficie-hadcruh/

@ Patrignani

a seguire i suoi commenti sembra che lei abbia intuito qualcosa di fondamentale che sfugge invece al resto della ignara comunità scientifica. Se è così mi domando perchè non pubblica su una rivista PR, in modo da sottoporre questi suoi argomenti anche fuori dai blog italiani e dai meteogiornali vari. A giudicare da quanto vi scrive, pare che il tempo non le manchi.

Diversamente: si rassegni a imparare e a prendere lezioni da chi ne sa più di lei. Le è mai venuto il dubbio che forse la comprensione del sistema climatico richieda qualcosa di più del programma excel? Le hanno mai fatto notare che, da qualche secolo, il progresso scientifico si avvale sopratutto di argomenti “quantitativi” e non solo speculativi?

Ebbene sì, calcoli, calcoli, calcoli noiosi, migliaia e migliaia di righe di codice, miliardi di miliardi di conti… La soprenderò ma, mi creda: questi calcoli servono anche a simulare il comportamento in atmosfera dell'”elemento più vitale e sacro e che esista, l’ACQUA”, e pure nelle sue varie forme, comprese a volte le più diversi varianti microfisiche solide o liquide.

@Stefano C.

non ho mai scritto che C. Costa è un mostro, nemmeno con la locuzione “mostro d’intelligenza”. Al massimo avrò scritto che ha fatto una cosa “mostruosa”, una descrizione che non riguarda la sua persona.

@C. Costa

Se dai dati che lei cita il 2010 è pari, secondo o terzo, chi dovrebbe notare che cosa, e come dovrebbe correggere “uno dei più caldi… forse il secondo”?

x patrignani; siamo alle solite: lei sta sostenendo che un ciclo di 60 anni sovrapponendosi nel modo giusto ha ingannato tutti o quasi i climatologi (eccetto lei, ovviamente); solita risposta: il clima è la media su lunghi periodi di vari decenni o secoli; gli ultimi decenni o secoli hanno mostrato un cambiamento indipendentemente dal ciclo da lei mostrato; l’era industriale dura ormai da più di 250 anni; entro questo periodo si è verificato qualcosa che non dipende da quel ciclo, ma dal crescente consumo di fossili (al 95%)

alla fine sotto a tutto c’è solo il rifiuto da parte di moliti uomini di accettare che essendo una forza geologica “cosciente” dobbiamo fare attenzione a dove mettiamo i nostri “piedi”; tutto qua

x Alessandro e i suoi cicli: concordo con quel che dice cdv.

In ogni caso: non puoi escludere che i tuoi cicli siano condizionati da correlazioni spurie, dal momento che non esistono robuste spiegazioni fisiche a monte. E c’è anche dell’altro.

il problema di questo (e di altri) presunti “cicli superiori” (solari, cosmici ecc. ecc.) associati a variazioni geofisiche è che molti fenomeni geofisici non si comportano in maniera completamente casuale, anche se non forzati da fattori esogeni.

Klaus Hasselmann, nel 1976, fu uno dei primi ad introdurre la stocasticità nei sistemi climatici. Rumori di fondo apparentemente random (come la fluttuazione giornaliera/mensile/annuale) di alcuni parametri meteorologici, in realtà, soggiaciono ad una sorta di “auto-condizionamento altamente conservativo”, quello che in statistica viene chiamata autocorrelazione.

In breve: se si osserva un valore di un certo tipo (ad es. elevato), c’è una buona possibilità che il valore temporalmente successivo, perlomeno per un certo periodo, sia pure dello stesso tipo. Questo, ovviamente, diminuisce la significatività statistica, dal momento che il numero di valori indipendenti viene fortemente ridotto da un’alta autocorrelazione.

Questo fa sì che molto spesso appaiano sovrapposizioni apparentemente molto interessanti fra due serie di dati (correlazione elevata) anche in assenza, oltre che di una robusta spiegazione fisica di fondo (cosa ben nota, correlation is not causation), di un robusto significato statistico.

@Cacciamani

Forse, nel suo esempio, intendeva scrivere F(t)= t + sin(t), anche se poi in effetti parlava di moltiplicazione.

F(t) = t*sin(t) rappresenta oscillazioni crescenti in ampiezza, il trend sarebbe zero.

A parte ciò, “warming” significa riscaldamento. Cioè, è una la grandezza derivata prima della temperatura. Se la F(t) vuole essere un esempio esemplificativo/qualitativo della T globale, allora il GW è costante, a parte la variabilità.

Se invece, per un numero di anni sufficiente a stabilire un trend, le temperature si mantenessero a livello alti, anche record, ma costanti come trend, allora dovremmo concludere che il GW è assente.

Perdonate la banalità, ma mi sembrava utile precisare.

% agrimensore

ovviamente ha ragione lei, il significato che volevo dire è che l’oscillazione si compone con il trend e mi è scappato (evidentemente sto perdendo dei colpi…) il “per” al posto del “piu’. Mi scusi l’errore. Il senso pero’ del mio discorso non cambia di un niente. Se la funzione rappresenta (ripeto: brutalmente e qualitativamente) un'”anomalia” (rispetto ad un clima di riferimento, vedasi IPCC AR4 ad esempio) allora converrà con me che se c’è un trend “positivo” (su scale temporali lunghe) significa che l’anomalia “cresce” nel tempo, cioè che se adesso vale +1 tra qualche decina d’anni varrà +1,5 gradi e cosi’ via…E questo non è un riscaldamento ? Questa cosa si “compone” (i.e. si somma) con la variabilità che opera su scale temporali più corte, che un anno puo’ mascherare completamente il riscaldamento dovuto al trend di più lungo periodo (ad esempio un anno molto piu’ freddo di quel clima di riferimento…). Come dire che tempo e clima sono faccende diverse.

@Steph

“x Alessandro e i suoi cicli: concordo con quel che dice cdv….”

Io no.

Ma comunque non mi interessa convincere nessuno, soprattutto chi pensa che quello 0,1-0,15° di aumento dovuto ai GHG (70% umani e 30% naturale, Ahrrenius) sia il responsabile dell’aumento di circa 1° da inizio 900 ad oggi per il tramite di fantomatici (e irriscontrati) feedback.

Buon proseguimento.

@Cacciamani

No, mi scusi lei se ho dato l’impressione di essere quello che vuol mettere i puntini sulle i. So bene che scrivere un commento, in breve tempo, non è come scrivere un articolo, il refuso può sempre scappare. Il senso del suo intervento era comunque chiaro. Se faccio delle precisazioni, è solo per cercare di evitare che la discussione si incanali su binari morti.

Comunque, a parte la funzione, se va in giro per i vari siti, vedrà che spesso si scrive che il GW è aumentato (o diminuito) a fronte di un aumento (o diminuzione) della temperatura, anzichè della variazione della temperatura. In questo caso, a parte il tema del trend vs. variabilità interannuale, c’è anche il tema di grandezza vs. derivata 1a (e vs. derivata 2a).

@Patrignani

Sono d’accordo che le perplessità sull’AGWT sia nella valutazione dei feed-back, cioè sulla valutazione della differenza tra quanto si ottiene in laboratorio e quanto presente nel sistema Terra.

@A. Patrignani

Vorrei correggere alcune imprecisioni sul nostro “fideismo”.

Questo blog parla di “problematiche climatiche” così come le ricerche alle quali rimanda, nessuna delle quali accenna a “comportamenti lineari”. Può verificarlo cliccando su qualche link, per esempio al punto 3 del post 27/1/2010. In particolare, se l’interessano i “comportamenti reali” e una risposta alla sua domanda sull’OHCA, Robust warming of the global upper ocean.

Un aumento del 23% o 38% o 158% non è “sparuto”.

x Patrignani:

ma che vuol dire:

chi pensa che quello 0,1-0,15° di aumento dovuto ai GHG (70% umani e 30% naturale, Ahrrenius) sia il responsabile dell’aumento di circa 1° da inizio 900 ad oggi per il tramite di fantomatici (e irriscontrati) feedback.

?

bah!

@ Patrignani

Lei propone “0,1-0,15° di aumento dovuto ai GHG”: se riesce a dimostrarlo penso che un bell’articolo su Science non glielo toglie nessuno.

Idem per il fatto che il 30% (presumo dell’eccesso dei gas serra rispetto all’epoca preindustriale”) sia di origine naturale.

Vede, per fortuna la scienza non procede sui blog. Qui si cerca solo di capirla meglio. E’ un po’ la differenza che c’e’ tra un campo di calcio ed un salotto di, magari anche arguti, commentatori televisivi.

Oggi avevo eliminato il commento di A. Patrignani perchè conteneva due violazioni alla netiquette (era il nono e conteneva due link)

visto che l’eliminazione è arrivata tardi e in contemporanea ha ricevuto risposte, lo aggiungo qui solo per far capire il senso dei commenti successivi

Commento di A. Patrignani

@agrimensore

Infatti. Qui in questo Blog si parla sempre di questioni che vengono in ogni modo “imputate” ad AGW e non si affrontano mai le vere problematiche Climatiche, cio’ il comportamento dell’atmosfera negli anni.

Avere un comportamento cosi’ “fideistico” sottointende una assoluta confidenza che i feedback atmosferici (85-90% di tutto l’aumento dell’ultimo secolo considerando il 10-15% secondo la legge di Ahrrenius) siano esclusivamente dovuti a quello sparuto aumento di GHG.

Ma chi ce la da tutta sta confidenza ? Bho !!!

Ma perche’ il Clima reale ha comportamenti tutt’altro che lineari (come dovrebbe essere la “teoria” AGW con la sua forzante in costante aumento nel tempo) come ad esempio la OHCA ?

Perche’ l’OHCA della zona tropicale ha visto due ben precisi scatti nel 76 circa e dopo il Nino 98 ?

http://globalwarming.blog.meteogiornale.it/2011/02/18/aggiornamento-stagionale-ohca-ocean-heat-content-anomalies/

http://globalwarming.blog.meteogiornale.it/files/OHCA11-tropical.jpg

Questo e’ spiegabilissimo guardando i comportamenti climatici reali, non e’ spiegabile con forzanti costanti.

Il post verra’ cancellato x netiquette, ma per risponedere a Paolo Gabrielli due cose:

– 1/6 di raddoppio CO2 uguale a circa 0,15° (sono spanne ovviamente)

– l’aumento di CO2 ha un chiaro andamento adeguato alle temperature medie, si guardi ad esempio il grafico dell’andamento della grow rate della CO2. Quindi mentre e’ evidente che una grossa fetta e’ di natura umana, per il fatto che la grow-rate rimanga positiva anche in situazioni di calo delle medie interannuale (esempio anni di Nina o vulcani), e’ evidente anche che una fetta dell’aumento sia attribuibile alle specifiche situazioni climatiche (Nino -> grow-rate maggiore, Nina grow-rate inferiore). Un numero esatto e’ difficile darlo, il 30% e’ un valore spannometrico che ho calcolato leggendo alcune variazioni di trend.

Sono contento che questo Blog si occupi di “capire meglio” il clima, pero’, mi consenta, non sembra che ci sia una apertura verso argomenti che in qualunque modo vadano ad “attutire” la teoria del riscaldamento dovuto principalmente all’Uomo.

Comunque vi saluto xche’ non posso + scrivere x netiquette.

@ Patrignani

Concludo anch’io. Solo per dire che:

1) Se la sensitivita’ climatica alle variazioni di CO2 fosse cosi’ bassa come sostiene lei (senza peraltro indicare alcun riferimento) non solo sarebbe impossibile spiegare il riscaldamento in corso ma anche le ampie variazioni di temperatura glaciale-interglaciale (solo per fare un esempio).

2) Lei confonde il rateo di aumento della concentrazione di CO2 con l’aumento stesso. Solo il rateo e’ influenzato in maniera significativa da fattori naturali mentre l’aumento di circa 110 ppm della CO2 rispetto ai valori preindustriali lascia spazio a soli pochi ppm di contributo naturale.

Infine ha ragione quando dice che su questo blog non c’e’ apertura verso le chiacchere. Quello che qui viene preso in considerazine sono i dati, verificati e comprovati attraverso il metodo della peer review. Questo metodo non garantisce certo che tutto quello che viene pubblicato sulle riviste scientifiche sia corretto (ci mancherebbe) ma costituisce quantomeno la base minima per cominciare la discussione.

Prendere invece dati, riportarli su un blog e poi ricamarci sopra delle teorie puo’ essere un interessante passatempo che rischia pero’ di confondere le idee a chi non e’ in grado di distinguere le fonti affidabili da quelle non (purtroppo la maggior parte delle persone). Grazie per il suo gentile contributo.

@Alessandro

Ultimo post anche per me.

Prima di tutto si scrive Arrhenius.

Secondo di tutto: la legge di Arrhenius permette di calcolare molto facilmente l’incremento termico dato da un ipotetico raddoppio di CO2, senza conseguenti feedback “rapidi”. Ed è di circa 1°, non meno. Il ∆RF per un raddoppio di CO2 vale 3.7 Wm^-2.

Ben altra cosa è calcolare la sensibilità climatica, cioè l’incremento termico dopo i feedback “veloci”. La stima, calcolata e inferita, è di circa 3 +/- 1.5 °C. Incertezze legate appunto all’ampiezza dei feedback (es. aerosol, inerzia per uptake oceanico, nuvole…).

http://img651.imageshack.us/img651/8702/climatesensitivitylg.gif

In un secolo abbiamo avuto un aumento della concentrazione di CO2 di circa il 35% e un incremento termico di 0.85 gradi C. Se applicasse la sola legge di Arrhenius (e quindi senza tener conto dei feedback e di altro, come detto), quindi, avremmo un aumento di 0.3 gradi C, 2.5*il valore che dici. Ma il ragionamento, ovviamente, è solo speculativo e puramente teorico. Ci sono altre forzanti in gioco (altri GHG, aerosol, ozono, albedo dato da land use, sole, vulcani,…), le solite cose note. E poi ci sono i feedback “veloci”. L’aumento di vapore è uno, l’amplificazione artica un altro, ad es.

“Grow-rate CO2”: ti invito a leggere il post “Fluttuazioni pacifiche” (27/6/2010) sul mio blog.

Provo cmq a mettere il link diretto, anche se è già il mio secondo in questo commento.

http://climafluttuante.blogspot.com/2010/06/fluttuazioni-pacifiche.html

@steph

A proposito di feed-back, sarebbe interessante anche una discussione sul funzionamento del “sistema” Terra. In particolare, cosa succederebbe se il livello di CO2 rimanesse costante? Come si comporta il transiente rispetto al regime? Quali sono i punti di equilibrio e come si raggiungono (cioè quali sono i feed-back che aumentano e diminuiscono per raggiungere l’equilibrio in assenza di forzanti)? Sono domande difficili da esprimere in un commento, chissà che non ci si possa fare un articolo… Una delle mie (e non credo solo mie) perplessità nasce dal fatto che non riesco a immaginare un sistema con feed-back positivi diretti (+CO2 –> + T e contemporaneamente +T –> + CO2) che non porti inevitabilmente alla “catastrofe”. Una bella illustrazione forse sarebbe utile.

P.S.: Ho apprezzato il suo post linkato nel commento. A parte la competenza, il fenomeno è spiegato bene e in poche righe. Se vuole, sa essere molto chiaro. Complimenti.

[…] 2010 è, al fotofinish con il 1998 l’anno più caldo di […]

agrimensore

i feedback non dipendono dalla presenza di una forzante ma solo dalla variazione di temperatura. Se improvvisamente mantenessimo costante la forzante, lo sbilanciamento radiativo permarrebbe per un po’, il tempo necessario affinchè la temperatura salga fino ad annullarlo; in questo lasso di tempo i feedback continuerebbero ad agire ugualmente.

Immagini un aumento di temperatura DTo dovuto ad una qualunque causa in assenza di feedback. L’azione di un feedback positivo farà aumentare ulteriormente la temperatura di una quantità f*DTo con f>0. A questo secondo aumento, sempre per effetto del feedback, se ne aggiungerà un’altro pari a f*(f*DTo)=f^2*DTo, poi un’altro f^3*DTo, e così via. Sommandoli, si ottiene DT=DTo*(1+f+f^2+f^3+…) dove DT è l’aumento totale di temperatura. Se f<1 ogni successivo aumento sarà sempre più piccolo del precedente; matematicamente, la serie converge ad un valore 1/(1-f) e quindi DT=DTo/(1-f). Se 0<f<1 si ha un’amplificazione del riscaldamento ma senza alcuna catastrofe.

E’ bene precisare che questa è un’approssimazione lineare valida solo per DT piccoli; non è quindi adatta (e non solo per questo) a diagnosticare il valore di f per cui si ha il cosiddetto runaway warming. La prenda solo a scopo illustrativo.

@Reitano

Sì, lo so che feed-back non dipendono dalla forzante.

Però trovo interessante quello che scrive dopo: anche un piccolo aumento di temperatura viene amplificato per quello che è il risultato di una seria geometrica. Lei scrive “senza alcuna catostrofe”. Beh, questo è vero solo se f<<1. Non mi giudichi pignolo, ma con la sua dimostrazione ha dimostrato che l’amplificazione ha un valore che va da 1 a infinito, estremi esclusi. Quale che sia la sua idea di catostrofe, credo sia inclusa in questo range. La mia lo è certamente.

Comunque, supponiamo pure f<<1. Abbiamo messo in evidenza come una variazione anche casuale di temperatura (la famosa variazione interannuale) dovrebbe comportare un’amplificazione della variazione della T _permanente_. Ad esempio, volendo seguire quest’impostazione, un’eruzione vulcanica, in assenza di altre forzanti, comporterebbe un raffredamento che _permane_ anche dopo la fine dell’eruzione e l’assorbimento degli aereosol/ceneri etc.

Tra l’altro avrei problemi a ricomporre l’equilibrio radiativo.

A me non sembra che il “sistema” Terra funzioni così. E’ per questo che rimango perplesso sull’AGWT.

Sarei curioso di leggere un bell’articolo sul tema.

agrimensore

legga fino alla fine quello che ho scritto, per cortesia, in particolare l’ultimo paragrafo.

Non è vero che un’eruzione vulcanica, come esempio, produrrebbe una variazione di T permanente; sinceramente non capisco come possa giungere a questa conclusione. Come lei stesso suggerisce, forse ha qualche problema con l’equilibrio radiativo.

@Reitano

Ho riletto fino alla fine (l’avevo già fatto). Riporto l’ultimo paragrafo del suo intervento:

“E’ bene precisare che questa è un’approssimazione lineare valida solo per DT piccoli; non è quindi adatta (e non solo per questo) a diagnosticare il valore di f per cui si ha il cosiddetto runaway warming. La prenda solo a scopo illustrativo.”

In che modo questo paragrafo mette in discussione il mio ragionamento? Forse i “DT” non sono piccoli? Forse è a solo “scopo illustrativo” quindi non si applica nella realtà? O cosa?

Comunque, lasciando perdere le eruzioni vulacaniche, cosa succede a fronte di una qualsiasi variazione pseudocasuale DT (piccola)? Lei ha spiegato che viene amplificata di un certo fattore. Ora chiedo, come (e se) questa variazione viene successivamente riassorbita, escludendo forzanti o altre variazioni pseudocasuali. Io credo che nella realtà venga riassorbita, ma faccio fatica a pervenire allo stesso risultato con la descrizione del sistema Terra a reazione positiva, così come previsto nell’AGWT.

Lei non capisce come faccio a giungere a certe conclusioni, allora provo a chiarire ulteriormente, ponendomi in assenza di forzanti e prima dell’era industriale: