La Repubblica dell’apocalisse

Le catastrofi economiche, geologiche, ambientali, sismiche e quant’altro non bastano più. Nella gara (giornalistica) alle iperboli sembra che siamo giunti al limite estremo, l’apocalisse.

Sul sito di Repubblica qualche giorno fa è stata pubblicata una notizia sconvolgente dal titolo, virgolettato per indicare una citazione, “Entro il 2100 temperature saliranno di 4 gradi: sarà un’apocalisse”. Nel testo dell’articolo, però, la citazione non compare.

Ho cercato di risalire alla fonte della notizia e sembra essere il Guardian, dove però di apocalisse non si parla. L’intervistato è Steven Sherwood che parla di un potenziale aumento di 4 °C come  “catastrofico piuttosto che semplicemente pericoloso”. Possiamo discutere se 4 °C possano essere considerati catastrofici o meno, ma l’apocalisse, cioè la fine del mondo, è un’altra cosa.

“catastrofico piuttosto che semplicemente pericoloso”. Possiamo discutere se 4 °C possano essere considerati catastrofici o meno, ma l’apocalisse, cioè la fine del mondo, è un’altra cosa.

A parte il problema terminologico, nell’articolo di Repubblica si legge anche di un clima terrestre che sarebbe “molto più sensibile di quanto si pensasse”. Neanche di questo si parla nell’intervista al Guardian. Sherwood parla piuttosto di un’esclusione dei modelli che forniscono una sensitività climatica più bassa, inferiore a 3 °C per un raddoppio della CO2, e di un conseguente restringimento dell’intervallo di incertezza su questa quantità. Certamente più corretto è il titolo di un post su RealClimate, “a bit more sensitive”.

Sostanzialmente corretto è il riassunto delle conclusioni dell’articolo recentemente pubblicato da Sherwood e altri; parlando del feedback delle nuvole, su Repubblica si legge che “queste nuvole diventeranno più rare e scomparirà lo schermo che ci protegge dal calore solare”.

Più in dettaglio, Sherwood e colleghi studiano il mescolamento atmosferico fra la bassa e la media troposfera calcolato da 43 modelli climatici e trovano che le differenze fra i modelli spiegano circa la metà della differenza nella sensitività climatica da essi fornita. Il meccanismo fisico sarebbe proprio la riduzione della copertura delle nuvole basse in un mondo che si riscalda. In altre parole, il feedback delle nuvole sarebbe positivo. Confrontando poi il mescolamento calcolato dai modelli con il comportamento del mondo reale, trovano che i modelli che hanno un mescolamento irrealistico sono quelli che hanno anche la minore sensitività climatica. Seguendo questo criterio riducono l’incertezza nel valore della sensitività climatica, innalzano il limite minimo dal valore di 1.5 °C del V Rapporto IPCC a 3 °C.

Nell’intervista al Guardian, Sherwood parla di un mondo 4°C più caldo come un posto dove si avrebbe la fusione dei ghiacci della Groenlandia e di parte di quelli dell’Antartide. In effetti, bisogna andare indietro diversi milioni di anni per trovare una temperatura stabilmente a questo livello, e l’artico era privo ghiacci. Certo, il processo di fusione, a meno di fenomeni di collasso improvviso al momento imprevedibili, è lento e richiederebbe diversi secoli. Nel frattempo però il livello del mare si innalzerebbe ad un ritmo maggiore, condannando diverse regioni e città costiere alla sommersione.

Ma un’altra affermazione credo debba essere evidenziata. Sherwood dice che un mondo di 4 °C più caldo “renderebbe la vita difficile, se non impossibile, in buona parte dei tropici”.

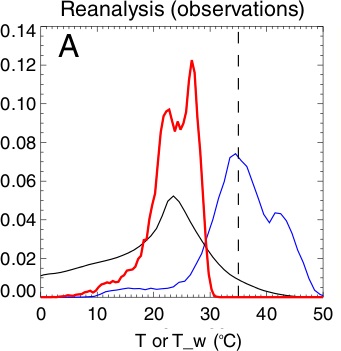

Sherwood si è precedentemente occupato del problema dell’abitabilità e non è quindi questa un’affermazione senza cognizione di causa. Benché gli uomini vivano in condizioni di temperature sia medie che massime estremamente diverse (rispettivamente curva nera e blu in figura), sappiamo tutti per esperienza personale che l’umidità dell’aria e la presenza di vento influenzano la percezione di caldo o freddo. Il concetto di temperatura percepita, che è entrato ormai da anni nel linguaggio divulgativo delle analisi meteorologiche, non ha però una base fisica solida. I meteorologi usano invece da tempo, anche se per tutt’altra ragione, la cosiddetta temperatura di bulbo umido. Possiamo immaginarla come misurata con un termometro ben ventilato il cui bulbo è coperto di garza bagnata; grazie all’evaporazione dell’acqua la lettura di temperatura sarà inferiore a quella di un termometro asciutto di una quantità che dipende dall’umidità relativa dell’aria. Il meccanismo è identico a quello che ci mantiene più freschi con l’evaporazione del sudore e quindi la temperatura di bulbo umido è “simile” alla temperatura percepita, ma ha una definizione fisica precisa.

Contrariamente alle altre, la distribuzione della popolazione in funzione della temperatura di bulbo umido (curva rossa in figura) è abbastanza stretta; ma, soprattutto, mostra un “taglio” netto dal lato ad alta temperatura.

Distribuzione della popolazione (frazione sul totale) in funzione della temperatura media (curva nera), della temperatura massima (curva blu) e della temperatura di bulbo umido media (curva rossa) espresse su base annuale e sui continenti. (Sherwood et al 2010).

La linea verticale tratteggiata rappresenta il valore limite fisiologicamente sopportabile. A quella temperatura di bulbo umido, infatti, il nostro organismo non è più in grado di disperdere nell’ambiente il calore inevitabilmente prodotto dai processi metabolici, così da andare incontro ad ipertermia.

La distanza fra il “taglio” della curva rossa e questa temperatura limite è considerato essere una sorta di “margine di sicurezza”, tale che anche durante le fluttuazioni interannuali della temperatura non ci si avvicini troppo o addirittura si superi la temperatura limite.

In un pianeta che si riscalda la curva rossa tende a spostarsi verso destra, avvicinandosi progressivamente al valore limite. Intere regione del pianeta, iniziando da quelle più calde e umide, rischiano di diventare progressivamente inabitabili, come affermato da Sherwood nell’intervista. E’ un limite fisico e fisiologico che non consente alcun adattamento.

Un pianeta 4 °C più caldo non sarà certo la fine del mondo, l’apocalisse (intesa come estinzione della quasi totalità delle specie, cosa avvenuta almeno cinque volte in passato); ma è molto probabile che l’impatto sul pianeta e conseguentemente sulla società umana non sarebbe certo cosa da poco. E’ un azzardo che l’umanità deve evitare.

Testo di Riccardo Reitano

21 responses so far

Non arriveremo così “tranquillamente” al 2100, ma neanche al 2050: http://www.ariannaeditrice.it/articolo.php?id_articolo=47111

Riguardo al discorso sulla temperatura di bulbo umido, segnalo uno studio della Climate Commission australiana che pone l’attenzione proprio sul fatto che nel prossimo secolo alcune cittá (nell’esempio specifico Darwin, in Australia), potrebbero avere climi con temperature che mettono a rischio la salute umana:

http://pandora.nla.gov.au/pan/136923/20130919-1415/climatecommission.gov.au/report/the-critical-decade-climate-change-and-health/index.html

Avremo la possibilità di assistere all’evento “dal di dentro”. Perché noi siamo una componente del sistema. E, detto per inciso, non abbiamo altro posto in cui vivere.

Tutto questo significa che succederà qualcosa di “grosso”, molto, ma molto tempo prima del 2100. Non ci resta che salire sul ponte del Titanic a goderci lo spettacolo, ricordando che molti naufraghi si sono salvati, magari dopo un bagno un po’ freddino nelle acque dell’Atlantico.

Un articolo come quello di Sherwood dà implicitamente e inequivocabilmente ragione a chi ha scritto, in tempi passati, di essere scettico sull’affidabilità dei modelli, e di conseguenza sulla sensibilità calcolata attraverso il loro uso, in particolare per quanto riguarda la simulazione delle nubi.

E’ come per l’IPCC: alla fine si scopre che è sempre più ottimista di quanto non dovrebbe…

agrimensore

l’effetto sulle nubi è indiretto, la simulazione o parametrizzazione della loro formazione non è coinvolta. Il problema evidenziato è sulla dinamica del mixing troposferico.

Paolo C.

l’IPCC più che “ottimista” è intrinsecamente “conservativa”. Non fa ipotesi, per quanto ragionevoli esse possano essere; si limita a prendere atto di ciò che è possibile affermare.

@Reitano

La simulazione della formazione delle nuvole basse è coinvolta. Cito l’abstract: “The apparent mechanism is that such mixing dehydrates the low-cloud layer…”. Avevo scritto simulazione, non parametrizzazione.

agrimensore

io non ho detto che non è coinvolta ma che è indiretto. Come la frase che citi conferma, il meccanismo è il mixing. Detto in altre parole, non sono le differenze nel come i diversi modelli trattano le nuvole ma in come trattano la dinamica del mixing verticale.

@agrimensore

“Un articolo come quello di Sherwood dà implicitamente e inequivocabilmente ragione a chi ha scritto, in tempi passati, di essere scettico sull’affidabilità dei modelli, e di conseguenza sulla sensibilità calcolata attraverso il loro uso, in particolare per quanto riguarda la simulazione delle nubi.”

In tutta onestà, fatico a capire il senso della sua puntualizzazione. Non è mai stato un mistero o un segreto per nessuno che fra i punti deboli dei modelli ci fossero le nubi e in particolare quelle basse. Vedi per esempio a pag 11 dell’ulitmo SPM dell’AR5:

“Uncertainty in the sign and magnitude of the cloud feedback is due primarily to

continuing uncertainty in the impact of warming on low clouds. {7.2}”

Del resto se il problema della sensibilità climatica fosse risolto la stessa IPCC non esprimerebbe tale valore con un range che è anche piuttosto largo. Addirittura nell’ultimo rapporto si è scelto, diversamente dal 4°, di non indicare la migliore stima (3°C, se non ricordo male).

Ecco, secondo me un articolo come quello di Sherwood, più che dare ragione agli scettici (evviva, applausi, tintinnio di bicchieri) dà ragione soprattutto a chi è molto preoccupato del pericoloso esperimento che stiamo conducendo con il clima dell’unico pianeta che abbiamo su cui vivere.

@Reitano

“io non ho detto che non è coinvolta…”

E invece l’hai detto (più precisamente, l’hai scritto): prova a rileggerti ciò che hai scritto, in particolare la prima riga nel tuo commento del 21 u.s. alle 14, 46

@homoereticus

Lo so anch’io che “non è mai stato un mistero o un segreto per nessuno che fra i punti deboli dei modelli ci fossero le nubi e in particolare quelle basse”. Il problema è che se qualcuno lo mette in evidenza rischia di essere chiamato “negazionista”. Così come quando si chiede una seria verifica sull’affidabilità dei modelli. Ha visto come ha fatto Sherwood? Li ha selezionati (anche piuttosto severamente, secondo me) in base al confronto con l’osservazione di quanto accade nel mondo reale, rilevando eventuali meccanismi fisici non implementati correttamente.

@ agrimensore

qui nessuno mi pare le abbia dato del “negazionista”.

Quanto al resto, dato che, come lei stesso riconosce, non ci sono nè misteri nè complotti, prendiamo tutti atto che la ricerca e gli studi sul clima continuano, alla luce del sole, e che impariamo oggi giorno qualcosa di più.

Chiudo con considerazione mia personale e ripetendomi: secondo me abbiamo già da molti anni imparato quanto basta per essere preoccupati e per capire che occorre prendere contromisure. La discussione non è accademica. Nel laboratorio dell’esperimento climatico che tanto ci appassiona ci siamo dentro noi, ed è un locale senza uscita d’emergenza.

Ma infatti ormai appare sempre più evidente che non ci saranno feedback negativi a salvarci; poi chi vuole illudersi faccia pure, finché può.

@homoereticus

Se per “qui” intende questo blog, le ricordo la seguente discussione

https://www.climalteranti.it/2012/04/19/perche-sbagliano-gli-scettici-del-riscaldamento-globale/

ove lei ha partecipato alla discussione, che verteva tra l’altro sulla formazione delle nubi, ma alla domanda se sia da considerare negazionista chi ha dubbi sull’affidabilità dei modelli, in particolare sulla sensibilità climatica calcolata per mezzo di essi, non ha voluto (o potuto, non posso escluderlo) rispondere. Come ha mostrato Sherwood, l’importanza delle nubi sulla stima della sensibilità è enorme. E, per citare il suo stesso commento:

“…se il problema della sensibilità climatica fosse risolto la stessa IPCC non esprimerebbe tale valore con un range che è anche piuttosto largo.”

Ecco, il mio tipo di scetticismo è ben rappresentato da questa sua frase.

Per il resto, non penso affatto a complotti, e se anche ci fossero, neanche mi interesserebbero.

@ Agrimensore

si rischia di ripetere una discussione già fatta. Le spiego come la vedo io. Quando Lei scrive:

“Un articolo come quello di Sherwood dà implicitamente e inequivocabilmente ragione a chi ha scritto, in tempi passati, di essere scettico sull’affidabilità dei modelli, e di conseguenza sulla sensibilità calcolata attraverso il loro uso, in particolare per quanto riguarda la simulazione delle nubi.”

sembra che essere sciettici sull’affidabilità dei modelli possa voler dire che i modelli sono affetti da gravi errori; ossia che prevedono un riscaldamento (per una dato scenario) di 3° quando le T potrebbero invece aumentare di 1, 0,5 o addirittura raffreddarsi.

Altra cosa è scrivere che ci sono ancora incertezze, che vanno ridotte, che i primi a saperlo sono i modellisti, ma che i risultati sono – nonostante le incertezze – robusti.

Cosa significa che i modelli “non sono affidabili” o viceversa che ” i loro risultati sono robusti”?. Che parametro consideriamo? C’è una soglia sotto la quale i modelli non sono affidabili e sopra lo sono? Ci affidiamo a gradi di probabilità… accettati nel settore? E chi lo decide?

Arrivo al punto. L’argomento da Lei citato “i modelli non sono affidabili” è stata a lungo usato per motivare la necessità di aspettare a prendere decisioni sulla riduzione delle emissioni. Su questo gli esempi sono a migliaia, i nonnni Lindzen e Singer da 20 anni ripetono questo, incuranti di tutti i cambiamenti.

In realtà il punto è che l’affidabilità già raggiunta dai modelli nello scorso decennio è molto molto maggiore di quella che servirebbe per consigliare di ridurre le le emissioni.

Il valore centrale della sensitività climatica è circa quello da 15 anni. In campo ambientale serve una precisione molto inferiore per decidere di agire.

Per questo, dire che “i modelli non sono affidabili” è a mio parere è sostanzialmente e chiaramente sbagliato.

agrimensore

sono abituato a pensare prima di scrivere, per questo so bene ciò che ho scritto senza bisogno di rileggerlo.

Forse è il caso di chiarire che la formazione delle nubi è un processo complesso che coinvolge svariati fattori. Sherwood ha definito dei parametri rappresentativi del mixing troposferico e li ha paragonati ai dati di rianalisi. Da questo ha dedotto che i modelli che danno risultati sul mixing in contrasto con i dati erano quelli con la sensitività minore. Alla base c’è quindi la simulazione del mixing troposferico. Le nuvole c’entrano indirettamente perchè il mixing troposferico è uno dei fattori che ne influenzano la formazione, quest’ultima essenzialmente parametrizzata essendo su piccola scala.

Se invece intendevi dire che i GCM simulano le nubi, hai ragione; ma sinceramente mi sembrava una ovvietà che si poteva dare per scontata.

Aggiungo solo un’altra cosa. I modelli (tutti e in tutti i campi) sono imperfetti per definizione e qualche particolare aspetto è più incerto degli altri. Ma è bene non dimenticare che gli errori sul risultato finale possono essere in entrambi sensi. Per esempio, rispetto ai 3 °C come valore “centrale” della sensitività climatica, potrebbe andarci meglio ma anche peggio. Puntare su un valore inferiore degli impatti dei cambiamenti climatici è, come da conclusione del post, un azzardo.

@Riccardo

bel post, avrei solo aggiunto che il modello francese è primo in classifica (kidding).

@agrimensore g

“i modelli non sono affidabili”

Strano che lei dica così. Sherwood et al. scrivono che su 48 soltanto 15 sono sotto il range inferiore delle osservazioni.

“selezionati severamente”

a me sembrano tutti i GCM meno i 5 che non stimano la sensitività. Quali mancano?

“negazionista… Così come quando si chiede una seria verifica sull’affidabilità dei modelli.”

Davvero? Mi dica chi chiama negazionisti Schmidt, Trenberth, Sherwood e tutti i modellisti che non solo la chiedono, ma la fanno e ne pubblicano mezza dozzina al mese. Vado subito a fargli una piazzata.

ocasapiens

attenta, qualcuno potrebbe dire che i francesi vincono la gara a chi la spara più grossa 🙂

@Caserini

Questo è il mio ultimo commento, ma trovo interessante il tema di definire quando un modello è affidabile e i risultati da esso prodotti robusti. chissà che un giorno ci sia modo di approfondirlo.

@Reitano

E’ proprio così convinto di non dover rileggere ciò che scrive? Riassumo:

-Reitano 21 gen ore 14,56

“l’effetto sulle nubi è indiretto, la _simulazione_ o parametrizzazione della loro formazione non è coinvolta” ==> la simulazione della formazione delle nubi non è coinvolta

– Agrimensore g 21 gen ore 18,24

“La simulazione della formazione delle nuvole basse è coinvolta”

– Reitano, 21 gen. Ore 18,50

“io non ho detto che non è coinvolta…”

Comunque, il cosiddetto mixing verticale ha impatti sulla formazione delle nubi basse che a loro volta hanno impatto notevole sulla sensibilità. Quindi, come è implementato il mixing nei modelli ha impatti sulla simulazione delle nubi, e quindi sul valore della sensibilità.

@oca sapiens: a me non manca nessun modello, la selezione è stata fatta da Sherwood in base alla corrispondenza degli output prodotti con la realtà in ottica ricalcolo sensibilità. Nella mia parentesi non c’era nulla di malizioso.

agrimensore

non ho voglia continuare questa discussione sterile. Si tratta dell’interpretazione della frase da te citata:

“l’effetto sulle nubi è indiretto, la _simulazione_ o parametrizzazione della loro formazione non è coinvolta”

e in particolare quel “simulazione o parametrizzazione della loro formazione”.

Ho provato a chiarire nelle risposte successive cosa intendevo. Non ci sono riuscito, me ne farò una ragione. In cambio forse io non ho capito cosa intendi tu per “simulazione delle nubi”, sono certo che anche tu te ne farai una ragione 🙂

Tornando a Sherwood, in quell’articolo non c’è nulla che possa dare inequivobilmente ragione a chi non crede ai modell, come dici tu; ha usato i modelli “classici” che danno il “range ufficiale” di sensitività. Rientrano nell’incertezza nota e documentata. Contrariamente al modo tuo modo di pensare, il lavoro di Sherwood rientra nel normale processo di perfezionamento dei modelli. Dire che i modelli non servono tout court senza una motivazione scientifica solida è chiaramente originato da un pregiudizio.

La dimensione minaccia alla pace dei cambiamenti climatici viene sottolineata dagli Stati Uniti:

John Kerry on Sunday called climate change perhaps the world’s “most fearsome” destructive weapon

e nel contempo

and mocked those who deny its existence or question its causes, comparing them to people who insist the Earth is flat.

Read more here: http://www.fresnobee.com/2014/02/15/3773329/in-indonesia-kerry-urges-action.html#storylink=cpy

Capito negazionisti?